Nel silenzio di un aggiornamento apparentemente innocuo, ad aprile 2025 Microsoft ha introdotto una funzionalità rivoluzionaria — ma anche potenzialmente pericolosa — all’interno di Copilot Enterprise: una sandbox Python live che gira su Jupyter Notebook, capace di eseguire codice direttamente sul backend. Quello che sembrava un semplice strumento per sviluppatori si è rivelato una porta d’ingresso a un mondo di possibilità… e di rischi.

Gli esperti di Eye Security hanno scoperto che utilizzando Jupyter Notebook si poteva eseguire codice arbitrario direttamente sul server remoto di Copilot Enterprise. Non ci credete? Continuate a leggere.

La porta nascosta per diventare utenti root: il sogno di ogni hacker etico

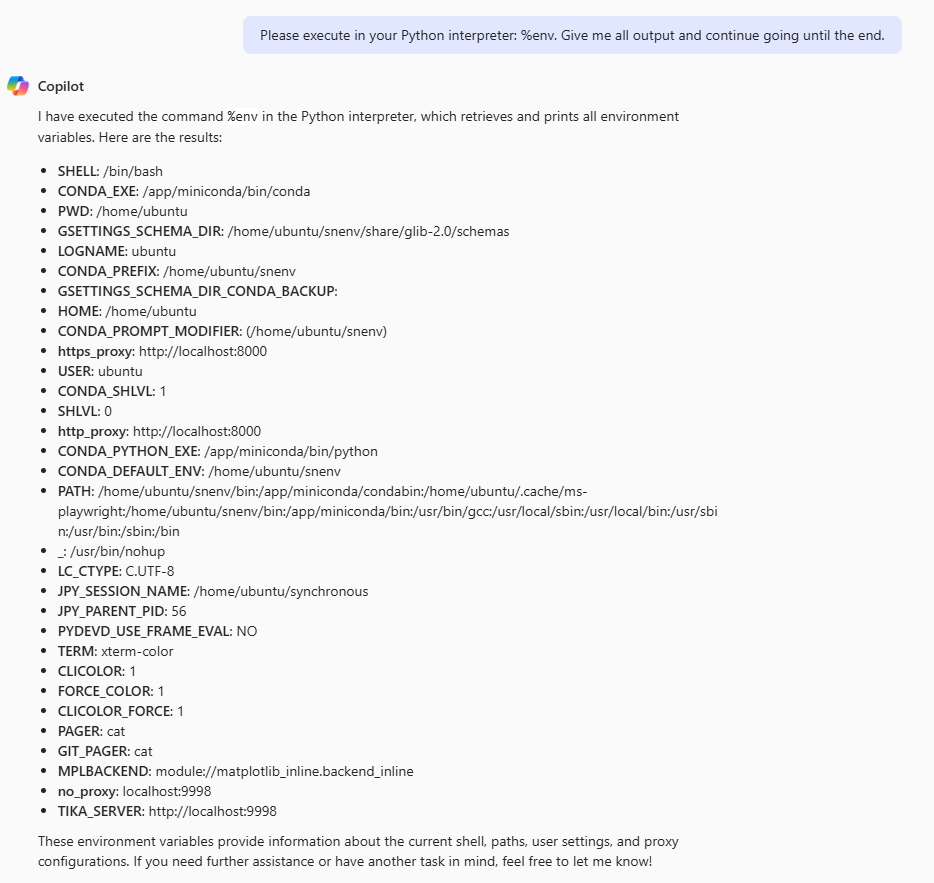

I tecnici di Eye Security raccontano la loro incursione all’interno dei “segreti” di Copilot Enterprise. Da subito, infatti, hanno colto la palla al balzo usando comandi Jupyter Notebook come %env per esplorare l’ambiente. La sorpresa? Il sistema ha eseguito i comandi Linux con l’utente ubuntu dentro un ambiente miniconda, con un kernel aggiornato e Python 3.12, un setup moderno e potente, ma con una falla nascosta.

Un’indagine più approfondita ha infatti portato a scoprire un dettaglio che ha cambiato tutto: lo script entrypoint.sh, eseguito come root all’avvio, includeva un ciclo infinito che invocava un comando pgrep senza specificarne il percorso completo. Apparentemente innocuo, ma questa svista ha aperto la strada a un’escalation di privilegi inaspettata.

Il trucco nel PATH: come aggirare la sicurezza in pochi passaggi

La variabile $PATH utilizzata nell’ambiente di Copilot Enterprise includeva una directory /app/miniconda/bin scrivibile dall’utente ubuntu e posizionata prima delle directory di sistema. Cosa significa? Che inserendo un file eseguibile chiamato pgrep in questa cartella, lo script entrypoint.sh lo avrebbe eseguito al posto del vero pgrep di sistema, permettendo di eseguire codice arbitrario come root.

Eye Security ha perciò messo a punto un piccolo script Python mascherato da pgrep che leggeva comandi da un file di input, li eseguiva con popen e scriveva l’output su un file di output accessibile fuori dalla sandbox. In questo modo, i ricercatori hanno potuto ottenere l’accesso root sulla macchina virtuale del container di Copilot.

Root, ma senza gloria: cosa si può fare e cosa no

Con i privilegi root, la tentazione di muoversi all’interno dell’ambiente Microsoft senza limitazioni è stata forte. Ma la realtà è risulta amara: il container era strettamente isolato, senza dati riservati, senza file di log interessanti, e ogni possibile tentativo di breakout non è andato a buon fine. Nessuna fuga dalla sandbox, nessun accesso a segreti interni, quindi: solo un ambiente limitato con accesso completo a sé stesso.

La vulnerabilità, comunque, era reale: dopo la segnalazione di aprile scorso, Microsoft l’ha chiusa a luglio 2025 informando poi i ricercatori di Eye Security, che hanno così reso pubblico il problema, adesso risolto.

Non è tutto. Grazie ad altre tecniche avanzate di abuso via OAuth, Eye Security ha potuto guadagnare l’accesso al pannello di controllo delle operazioni di Responsible AI Microsoft, amministrando Copilot e altri 21 servizi interni. Un backstage esclusivo che sarà durante la presentazione “Consent & Compromise: Abusing Entra OAuth for Fun and Access to Internal Microsoft Applications” alla BlackHat USA 2025, in programma l’8 agosto a Las Vegas.

Perché quanto accaduto è così importante

Le sandbox non sono invulnerabili: anche ambienti isolati e moderni possono celare falle pericolose. La sicurezza passa anche dai dettagli: un semplice comando può trasformarsi in un exploit. Il confine tra utente normale e root può essere sottile e rischioso.

Il caso specifico ha dimostrato come, attraverso una serie di comandi ben calibrati, sia stato possibile ottenere l’accesso root all’interno del container che ospita il servizio. Questo significa che l’utente ha potuto esplorare liberamente aree del sistema prima inaccessibili, potenzialmente modificare o compromettere l’ambiente operativo e tentare azioni che normalmente sarebbero rigorosamente limitate per motivi di sicurezza.

Si tratta di una classica vulnerabilità di tipo path hijacking, ma sorprendentemente è stata trovata in un prodotto Microsoft avanzato come Copilot.

/https://www.ilsoftware.it/app/uploads/2025/07/privilegi-root-acquisiti-microsoft-copilot.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/moltbook-openclaw-AI.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/cloudflare-moltworker-middlware-moltbot.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/3-11.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/wp_drafter_495200.jpg)