/https://www.ilsoftware.it/app/uploads/2025/08/studio-google-consumo-energetico-AI-gemini.jpg)

Negli ultimi anni, l’intelligenza artificiale ha compiuto progressi straordinari, passando dal regno degli strumenti sperimentali a tecnologie adottate su larga scala per ricerca scientifica, medicina, istruzione, intrattenimento e business. Secondo diverse stime, l’AI potrebbe generare migliaia di miliardi di dollari di valore aggiunto per l’economia globale nei prossimi anni. Tuttavia, a fronte di questi benefici, resta un tema cruciale: qual è il costo ambientale dell’AI? Capire l’impronta ecologica dei modelli di ultima generazione, come Google Gemini, è fondamentale per bilanciare sviluppo tecnologico e sostenibilità.

Quanto consuma una richiesta a Gemini?

Google ha recentemente pubblicato uno studio che misura il consumo energetico e l’impatto ambientale delle interazioni con i propri modelli. Dai dati emerge che l’elaborazione di un singolo prompt testuale da parte di Gemini consuma in media:

- 0,24 Wh di energia

- 0,03 g di CO₂ equivalente

- 0,26 ml di acqua

Per rendere tangibili questi numeri, Google li ha paragonati a meno di 9 secondi di visione televisiva e al consumo di circa cinque gocce d’acqua. Sono dati complessivamente irrilevanti rispetto ad attività digitali di massa come lo streaming video, che rimane di gran lunga più energivoro.

Uno degli aspetti più significativi dell’indagine elaborata dalla società di Mountain View, riguarda i progressi in termini di efficienza. In appena 12 mesi, Google dichiara di aver ridotto i consumi energetici medi per prompt di 33 volte; le emissioni di CO₂ di 44 volte.

Tutto questo, mantenendo una qualità delle risposte superiore grazie a innovazioni software, architetturali e hardware, oltre ai progressi dei data center nell’uso di energie rinnovabili e tecniche di raffreddamento a basso impatto.

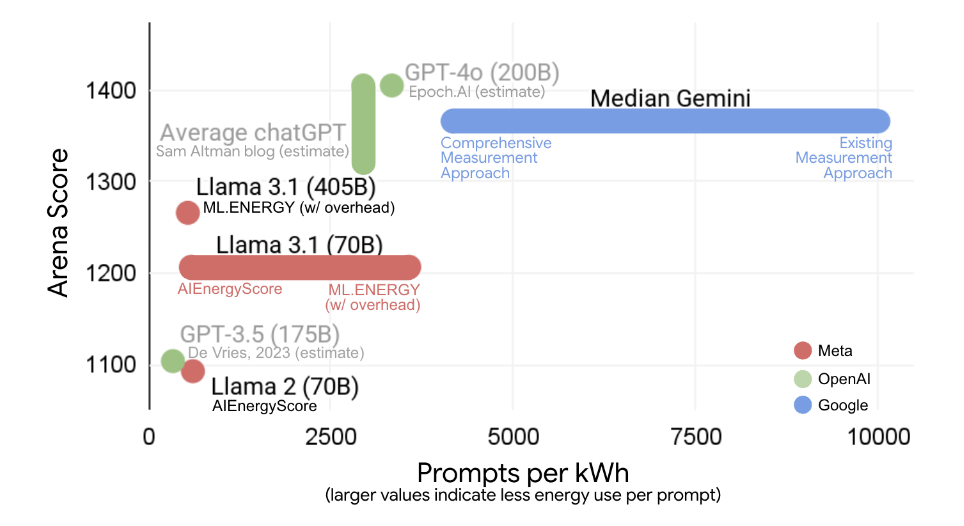

Un approccio metodologico completo: oltre le sole GPU e TPU

Molti calcoli diffusi in passato hanno considerato solo il consumo dei chip specializzati (GPU, TPU). Google invece ha sviluppato un approccio più realistico, che include la potenza dinamica dell’intero sistema, non solo il carico massimo teorico; le macchine inattive, mantenute operative per gestire picchi di traffico e garantire affidabilità; CPU e RAM, che supportano l’esecuzione dei modelli accanto agli acceleratori AI; l’overhead del data center, come raffreddamento, distribuzione elettrica e altri apparati (misurati tramite PUE, Power Usage Effectiveness); il consumo idrico dei data center, impiegato nei sistemi di raffreddamento.

Applicando un calcolo semplificato (solo TPU/GPU attivi), l’impatto stimato scenderebbe a 0,10 Wh, 0,02 g di CO₂ e 0,12 ml d’acqua per prompt. Ma questa rappresenta una stima ottimistica e incompleta, che sottovaluta l’impronta reale. Con il metodo esteso, i valori salgono ai dati ufficiali indicati in precedenza, fornendo un quadro più accurato del consumo effettivo su scala globale.

Il vantaggio di Gemini: architetture, algoritmi e hardware su misura

I progressi di efficienza fatti registrare da Gemini derivano da un approccio full-stack, che integra hardware, software e data center:

- Architetture più efficienti: Gemini sfrutta Transformer avanzati, Mixture-of-Experts (MoE) e ragionamento ibrido. Con MoE, solo una parte del modello viene attivata, riducendo i calcoli fino a 100 volte.

- Algoritmi ottimizzati: tecniche come Accurate Quantized Training (AQT) migliorano l’efficienza, mantenendo la qualità delle risposte.

- Ottimizzazione dell’inferenza: metodi come lo speculative decoding e la distillazione (con modelli come Gemini Flash e Flash-Lite) riducono drasticamente il carico computazionale.

- Hardware custom: le TPU di Google, sviluppate da oltre un decennio, hanno raggiunto con la generazione Ironwood un’efficienza energetica 30 volte superiore rispetto alla prima versione pubblica.

- Gestione dinamica delle risorse: modelli e carichi sono spostati in tempo reale per minimizzare l’inattività delle TPU.

- Data center ultra-efficienti: Google dichiara un PUE medio di 1,09, tra i migliori del settore.

- Gestione responsabile dell’acqua: utilizzo di strategie di water replenishment (reintegro delle risorse idriche) e analisi locali per ottimizzare i sistemi di raffreddamento.

Dalla percezione ai dati: il confronto tra l’analisi Google e i precedenti studi sull’impatto ambientale dei LLM

Il recente studio pubblicato da Google si inserisce nel solco delle riflessioni pubblicate a suo tempo da Andy Masley, che sostiene come ChatGPT e soci non facciano male al pianeta.

In entrambe le analisi emerge come la percezione pubblica tenda spesso a concentrarsi su numeri isolati e impressionanti, ma privi del necessario contesto. Google ribadisce che l’uso dei LLM (Large Language Models), pur richiedendo risorse energetiche e idriche non trascurabili, va compreso nel quadro più ampio del sistema digitale e dei benefici prodotti: il consumo per query rimane marginale se confrontato con altre attività digitali di massa, mentre l’efficienza e il valore generato in termini di produttività, ricerca ed educazione possono giustificare il bilancio energetico.

In sostanza, il vero nodo non è “se” usare i LLM, ma “come” integrarli in un ecosistema tecnologico e industriale sempre più orientato alla decarbonizzazione e alla sostenibilità complessiva. Il problema non è l’uso dell’AI in sé, ma il mix energetico su cui si appoggia.

Le immagini nell’articolo sono tratte dallo studio elaborato da Google.

/https://www.ilsoftware.it/app/uploads/2026/01/raspberry-pi-AI-HAT-2-plus.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/sviluppo-agenti-ai-copilot-studio-VS-Code.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/costi-smartphone-crescita-2026.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/google-personal-intelligence.jpg)