/https://www.ilsoftware.it/app/uploads/2025/07/Regolo-AI-Seeweb.png)

L’intelligenza artificiale è diventata uno strumento indispensabile per gli sviluppatori e le aziende che vogliono rimanere competitivi. Accedere agli LLM può rivelarsi però costoso, sia dal punto di vista dell’implementazione di un’infrastruttura adeguata che da quello dell’impiego di risorse. Si pensi ad esempio agli oneri legati all’interazione con le API dei modelli generativi. Per questa ragione Seeweb, Cloud Computing Provider Europeo con una posizione di leadership nei servizi per l’AI e il Machine Learning, ha deciso di presentare Regolo.ai, una soluzione con cui rendere le potenzialità dell’intelligenza artificiale accessibili a tutti gli sviluppatori.

Ma come ottenere questo risultato riuscendo ad assicurare nel contempo sicurezza dei dati, trasparenza e sostenibilità ambientale? Il team di Seeweb, che è anche uno dei principali web hosting provider oggi sul mercato, propone un’infrastruttura AI full-stack, open e green dotata di modelli accessibili attraverso API e ottimizzati per coniugare efficienza e semplicità d’uso. Scopriamone le principali caratteristiche e i vantaggi per la massimizzazione della produttività.

Regolo.ai: quando l’AI diventa accessibile

Un inference provider è un servizio che permette di eseguire l’inferenza degli LLM supportando la generazione di risposte alle richieste di utenti e applicazioni. Questi ultimi forniscono un input, ad esempio un prompt espresso in linguaggio naturale, e ricevono un output dal modello di riferimento che, a seconda dei casi, può essere un testo, un’immagine o un altro tipo di contenuto. Ed è qui che entra in gioco un inference provider come Regolo.ai, una soluzione che offre diversi benefici in termini di scalabilità, efficienza e personalizzazione accelerando le risposte degli LLM.

Il servizio rende l’AI più accessibile in quanto rimuove le complessità relative all’integrazione tra modelli e applicazioni, riduce i tempi che separano sviluppo e deploy e permette di contenere i costi. Non è poi un caso che lo slogan scelto da Seeweb per Regolo.AI sia “Open for you but private for your business“, gli sviluppatori hanno infatti la massima libertà nel lavorare con l’AI in quanto non sono previsti lock-in da parte dei vendor di LLM. Nello stesso tempo viene garantita la riservatezza dei dati, indispensabile in ambito professionale, che rimangono di proprietà del titolare e disponibili solo per quest’ultimo anche una volta utilizzati per l’addestramento dei modelli.

Con Regolo.AI si hanno a disposizione tutte le risorse necessarie per sviluppare progetti con l’AI, sia in fase di elaborazione che di implementazione dei modelli. Il tutto avviene all’interno di un ambiente europeo, tramite data center localizzati in Italia, e in piena conformità con quanto previsto dalle normative UE in tema di raccolta, protezione e conservazione dei dati. Come il GDPR.

Oltre alla tutela della privacy e alla sovranità digitale il servizio di Seeweb garantisce anche un basso impatto ambientale e una riduzione dell’impronta di carbonio in quanto basato su infrastrutture alimentate con fonti rinnovabili e non con combustibili fossili. La dashboard di Regolo AI permette anche di monitorare i consumi energetici con la possibilità di consultare i dettagli relativi ai Watt consumati per token.

Una piattaforma Serverless AI on GPU per l’esecuzione degli LLM

L’infrastruttura Cloud di Regolo.ai si avvale di Kubernetes, vero e proprio standard di fatto in tema di orchestrazione, per l’esecuzione parallela dei task animati dalle AI. Il modello di tariffazione pay as you go permette inoltre di estenderla rapidamente con il vantaggio di pagare esclusivamente per le risorse utilizzate.

Quando parliamo di Regolo.ai ci riferiamo ad una piattaforma Serverless AI on GPU, con il vantaggio di combinare serverless computing e potenza delle GPU. Questo significa che si ha la possibilità di eseguire modelli di intelligenza artificiale su GPU senza la necessità gestire una propria infrastruttura server. Si ha bisogno di una maggiore quantità di risorse? Queste ultime sono sempre attivabili quando servono e ciò consente di supportare inferenze anche molto rapide ed intensive.

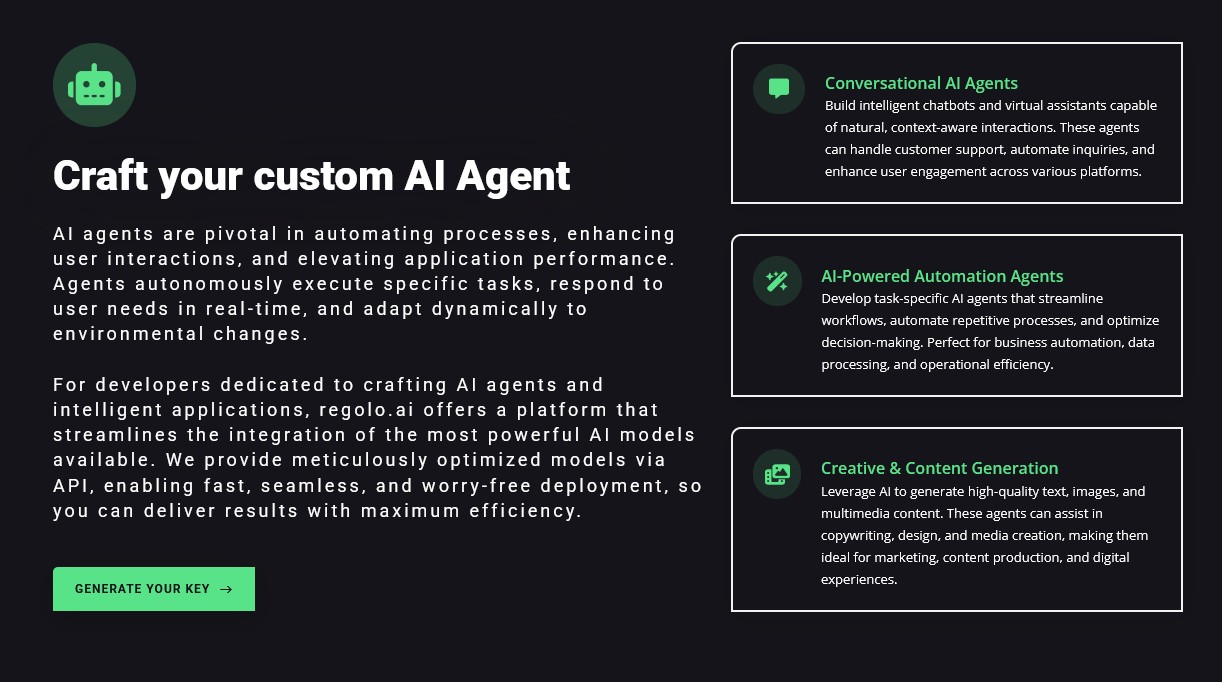

La validità di questo approccio diventa evidente quando si ha la necessità di implementare e personalizzare gli Agenti AI. Grazie ad essi i task possono essere assegnati direttamente agli LLM che provvederanno ad eseguirli in piena autonomia. Gli agenti AI possono sostituirsi agli utenti nelle conversazioni via email, nel fornire assistenza ai clienti in tempo reale, nel programmare spostamenti, nella ricerca sul web così come in altri compiti specifici e hanno la capacità di adattarsi al contesto di una richiesta e ai suoi cambiamenti.

Non esiste però un solo tipo di Agente AI e con Regolo.AI è possibile implementarli perché portino a termine compiti specifici. Abbiamo infatti:

- Agenti conversazionali: permettono di sfruttare gli LLM per la realizzazione di chatbot intelligenti e assistenti virtuali. Se utilizzati in ambiti di applicazione come per esempio il supporto clienti o l’assistenza tecnica, sono in grado di garantire delle interazioni naturali che tengono conto del contesto di una richiesta. Possono essere quindi delle soluzioni ideali per massimizzare engagement e fidelizzazione degli utenti.

- Agenti AI autonomi: sono particolarmente adatti per l’automatizzazione e l’ottimizzazione dei workflow. Sviluppati per portare a termine task predefiniti, possono sostituire l’uomo in diversi compiti che prevedono procedure ripetitive come l’elaborazione dei dataset. Date le loro caratteristiche, permettono di liberare risorse preziose per lo svolgimento di mansioni creative e facilitano i processi decisionali in ambito aziendale.

- Agenti per la creatività e la generazione dei contenuti: hanno la capacità di assistere i professionisti in task legati al copywriting, al design e alla creazione di media. Sono in grado di produrre testi, immagini e contenuti multimediali, per questa ragione risultano degli alleati preziosi nelle campagne di marketing, nella creazione di contenuti per i social media e nell’ottimizzazione delle esperienze digitali.

Un inference provider, tanti LLM

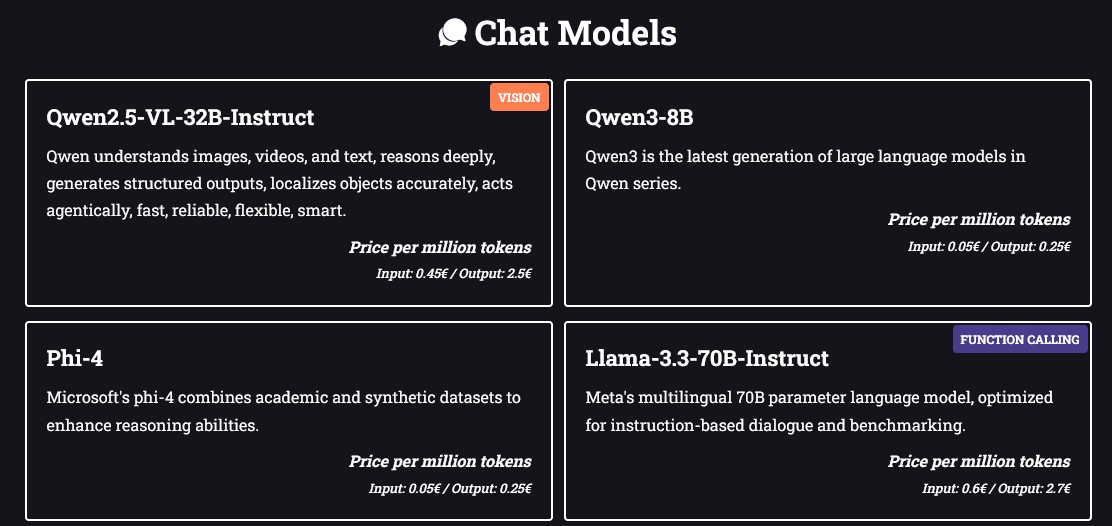

Regolo.ai si caratterizza per una grande disponibilità di LLM suddivisi in categorie legate ai loro ambiti di applicazione. Abbiamo così chat models con capacità multimodali, image generation models per la produzione di contenuti visuali anche fotorealistici ed embedding models con i quali interagire tramite un Python Client dedicato che consente di interfacciarsi alle API dei modelli.

La scelta è molto ampia con la possibilità di implementare LLM delle famiglie Qwen (Alibaba), Llama (Meta), Phi (Microsoft), maestrale (Mistral), DeepSeek e LongWriter. Non mancano poi soluzioni di Stable Diffusion e FLUX per la generazione di immagini. In tutti i casi sono disponibili i prezzi per milione di token (sia in input che in output) e per milione di pixel.

L’utilizzo è immediato, per iniziare è richiesta semplicemente la creazione di un account con il quale autenticarsi. Fatto questo si può accedere alla sezione “Virtual Keys” per generare la propria API Key e selezionare uno o più dei modelli a disposizione. Selezionandoli tutti la chiave creata potrà essere utilizzata indipendentemente dal modello in uso. L’impiego del Regolo.ai Python Client è consigliabile per la sua semplicità ma non vincolante, questo perché viene garantita la piena compatibilità con le API di OpenAI e la sua libreria Python.

Conclusioni

In un momento storico in cui l’intelligenza artificiale rappresenta il principale motore per la crescita e l’innovazione, Regolo.ai di Seeweb si propone come un alleato affidabile e accessibile ad ogni sviluppatore. La sua infrastruttura full-stack, Made in Italy, europea e sostenibile, unisce potenza computazionale su GPU e semplicità serverless, caratteristica che facilita l’inferenza degli LLM senza dover fronteggiare particolari complessità infrastrutturali.

L’ampia scelta di modelli, l’approccio open e l’assenza di lock-in assicurano flessibilità, privacy e controllo sui propri dati, tutti aspetti fondamentali in contesti professionali. Inoltre, la possibilità di sviluppare Agenti AI personalizzati apre nuove prospettive in termini di automazione, customer care e creatività. ConRegolo.ai, l’infrastruttura cloud di Seeweb concretizza le opportunità offerte da un’intelligenza artificiale aperta, sicura ed efficiente che mette al centro non solo la tecnologia ma anche le esigenze di chi la utilizza ogni giorno. Una piattaforma pensata per accelerare i progetti AI nel rispetto dell’ambiente e delle normative europee sulla protezione dei dati.

Grazie all’infrastruttura europea ad alte prestazioni di Regolo.ai, aziende e professionisti possono contare su una piattaforma AI full-stack alimentata al 100% tramite energie rinnovabili con accesso immediato alle API, sicurezza e privacy. Un ambiente completo con cui creare chatbot AI personalizzati, Agenti AI, motori di ricerca semantici e applicazioni per la trascrizione di audio in tempo reale, il riassunto automatico delle e-mail e la generazione di contenuti.

Se vuoi mettere alla prova le potenzialità di Regolo.ai, oggi puoi approfittare di una promo che ti permetterà di accedere gratuitamente al servizio per tutto il mese di settembre.

In collaborazione con Seeweb.

/https://www.ilsoftware.it/app/uploads/2026/01/cloudflare-moltworker-middlware-moltbot.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/3-11.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/wp_drafter_495200.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/agentic-vision-gemini.jpg)