/https://www.ilsoftware.it/app/uploads/2023/05/img_21981.jpg)

Siete alla ricerca di qualche suggerimento per scegliere una TV da utilizzare negli anni a venire, anche e soprattutto per accedere con la massima qualità alle varie piattaforme di streaming online, per effettuare il mirroring del PC o comunque per utilizzarla anche come monitor? Nel seguito proviamo a condividere qualche consiglio utile per selezionare il modello più adatto alle vostre esigenze.

Dimensioni dello schermo: la diagonale del pannello

Sia che stiate cercando un TV di base o un modello di alta gamma, uno degli aspetti più importanti sta nella scelta della corretta dimensione dello schermo.

Le scelte tipiche di oggi ricadono su dimensioni comprese tra i 55 e i 65 pollici ma tutto dipende dalla dislocazione del televisore e dalla distanza alla quale si guarderà lo schermo.

Una buona regola empirica è che ci si deve sedere a una distanza dal televisore che è 3 volte maggiore dell’altezza dello schermo per il Full HD e 1,5 volte l’altezza dello schermo per i modelli dotati di pannello 4K UHD. In altre parole, è possibile sedersi due volte più vicini a un TV 4K UHD.

Risoluzione: Full HD, 4K o 8K

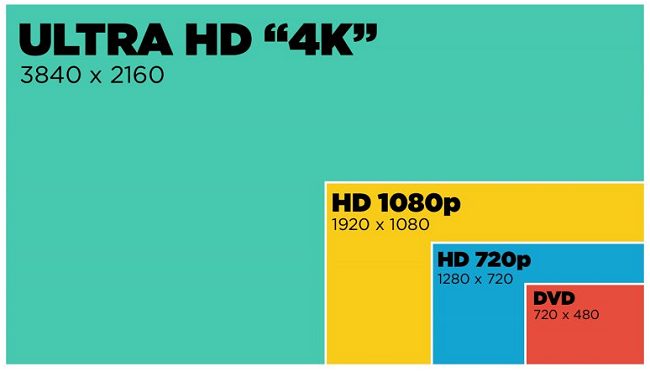

La risoluzione descrive il numero di pixel che compongono l’immagine sullo schermo in termini di righe orizzontali e colonne verticali. Più pixel si traducono in immagini più nitide e dettagli più fini, quindi una risoluzione più alta è (quasi sempre) migliore.

Per molti anni il Full HD (1080p, 1920×1080 pixel) è stato lo standard ed è ancora oggi la risoluzione più comune nei TV utilizzati a livello mondiale.

Da tempo, però, i produttori di televisori sono passati a pannelli 4K UHD che vantano un numero di pixel quattro volte superiore: 2.160 linee orizzontali (3840 x 2160 pixel).

Il più grande vantaggio dei TV 4K UHD è che gli elementi di ridotte dimensioni vengono resi con dettagli maggiori e il testo appare più nitido. Le immagini saranno più ricche e più realistiche rispetto a quelle di un televisore Full HD. Ne abbiamo parlato nell’articolo Differenza 4K e UHD: ecco cosa cambia.

Reperire contenuti 4K non è più un problema: diverse piattaforme streaming come Netflix, Amazon Prime Video, Disney+, Infinity, Rai Play e persino YouTube offrono contenuti in “ultra alta definizione“.

I primi televisori 8K a prezzi accessibili sono stati lanciati sul mercato quest’anno e altri ne usciranno nei prossimi mesi.

Si tratta di prodotti dotati di un pannello che quadruplica la risoluzione 4K offrendo un gigantesco balzo in avanti nella qualità dell’immagine. Ad oggi però non esiste alcuna disponibilità di contenuti 8K quindi è di fatto inutile “svenarsi” per acquistare un televisore del genere.

Le prime console 4K sono in uscita entro Natale 2020 e il supporto 8K in ambito gaming ci metterà probabilmente anni per essere introdotto: Il capo del progetto Xbox crede poco al passaggio alla risoluzione 8K.

In conclusione, ove possibile è bene oggi orientarsi sempre e comunque su TV 4K UHD scegliendo modelli Full HD solo nel caso in cui si avesse l’esigenza di acquistare un televisore di piccole dimensioni, tra 20 e 40 pollici.

HDR10, HDR10+ e Dolby Vision. Per una più ampia gamma cromatica

HDR (High Dynamic Range) è una caratteristica introdotta con i TV 4K UHD che consente di avere immagini con una più ricca gamma di colori, bianchi più luminosi e neri molto più profondi.

Lo standard di base per i contenuti ad alta gamma dinamica si chiama HDR10 così come stabilito dalla UHD Alliance. La presenza dell’indicazione HDR10 o Ultra HD Premium ne conferma il supporto da parte del televisore.

HDR migliora la “qualità dei pixel” con la possibilità di godere di immagini molto più realistiche e aderenti alla realtà. La natura, evidentemente, offre una gamma di colori molto più ampia rispetto a quella che un TV può provare a riprodurre ma l’idea è quella di avvicinarsi il più possibile.

Gli schermi HDR10 usano un pannello a 10 bit (1 miliardo di colori) mentre i più costosi Dolby Vision usano 12 bit permettendo la resa di 70 miliardi di colori.

Con i primi, inoltre, si possono gestire immagini con una luminosità fino a 1.000 nits mentre con Dolby Vision si può arrivare fino a 10.000 nits.

Ogni TV con supporto HDR integrato è attualmente compatibile con HDR10 mentre Dolby Vision si trova solo su quei prodotti che soddisfano gli standard tecnici Dolby e per lo sviluppo e la commercializzazione dei quali sono state versate le royalty.

Per approfondire, vedere l’articolo HDR10, HDR10+ e Dolby Vision: le principali differenze.

In collaborazione con Amazon, Samsung ha introdotto il suo formato premium HDR, chiamato HDR10+ che viene utilizzato su tutte le sue smart TV.

HDR10+ è uno standard aperto come HDR10 e può essere utilizzato senza versare alcuna royalty. Dal punto di vista tecnico porta a 4.000 nits il livello massimo di luminosità ottenibile e gestisce metadati dinamici su ogni singolo frame che compone la scena. Il televisore può così sempre sapere quando ottimizzare la luminosità per ottenere il risultato migliore possibile.

È comunque importante riflettere sul fatto che le immagini ottimizzate grazie a HDR10, HDR10+ e Dolby Vision sono comunque delle (ottime) approssimazioni del “reale”: Quanti colori può vedere l’occhio umano? Perché usare HDR10 e Dolby Vision.

HDR10+ offre un’eccellente esperienza visiva ma è molto meno comune rispetto al Dolby Vision. Contenuti HDR10+ si trovano su Amazon Prime Video e una manciata di Blu-Ray UHD (va tenuto presente che molti lettori Blu-ray UHD non supportano affatto il formato HDR10+). Il più semplice formato HDR10 gode di una compatibilità e interoperabilità praticamente universale.

Sia Technicolor che IMAX hanno anche portato sul mercato i propri standard proprietari, chiamati rispettivamente Technicolor Advanced HDR e IMAX Enhanced. È ancora troppo presto per sapere se uno di questi due nuovi formati avrà un qualche tipo di impatto sul mercato.

Frequenza di refresh: più elevata è, meglio è

La frequenza di refresh espressa in Hertz indica quante volte al secondo un’immagine viene aggiornata sullo schermo. La frequenza di aggiornamento standard è pari a 60 Hz.

Nelle scene con oggetti in rapido movimento, una frequenza di aggiornamento di 60 Hz può far apparire gli elementi sfocata o “mossi”, in particolare sui TV LCD Full HD.

Per ottenere un’immagine migliore i produttori hanno quindi raddoppiato la frequenza di refresh portandola a 120 Hz e in alcuni casi fino a 240 Hz.

Poiché nei contenuti video originali non sono state registrati così tanti frame in un secondo, i TV usano degli espedienti per rendere più stabile l’immagine ad esempio inserendo frame neri o generando immagini intermedie. I risultati possono però essere tutt’altro che entusiasmanti.

Alcuni nuovi modelli vantano il supporto High Frame Rate (HFR): questi TV supportano sia una frequenza di refresh più elevata rispetto ai 60 Hz standard, sia consentono di gestire contenuti video acquisiti con frequenze di aggiornamento maggiori.

Con i contenuti compatibili HFR (ad esempio film ma anche eventi in diretta) la differenza è davvero tangibile.

Attenzione all’eventuale utilizzo del termine “effective refresh rate“: ciò significa che la frequenza di refresh effettiva è la metà di quella dichiarata (ad esempio, una “frequenza di aggiornamento effettiva di 120 Hz” corrispondente a una frequenza di refresh di 60 Hz).

Il numero delle porte HDMI è importante

Alcuni produttori che cercano di ridurre i costi propongono TV con poche porte HDMI sul retro. Ed è questo un aspetto da non sottovalutare: collegando una chiavetta Chromecast, una soundbar e una console di gioco si occuperanno subito tre porte HDMI.

Nel caso in cui foste orientati sull’acquisto di un televisore 4K UHD, è bene assicurarsi che le porte siano almeno di tipo HDMI 2.0. Molti televisori hanno una sola porta che supporta lo schema di protezione anticopia 4K conosciuto come HDCP 2.2.

Nell’articolo HDMI 2.1, come funziona e quando ce ne sarà bisogno abbiamo parlato del nuovo formato HDMI 2.1 che ha iniziato a fare capolino sui televisori di più recente fattura.

In questo caso l’aspetto degno di nota è soprattutto il supporto per il meccanismo VRR (Variable Refresh Rate) che consente di ridurre la latenza e gestire il frame rate in maniera dinamica similmente a quanto fanno le tecnologie FreeSync di AMD e G-SYNC di NVidia.

Collegando il televisore a una sorgente “intelligente” come la scheda grafica del PC o la console di gioco, le azioni risulteranno più fluide senza il fenomeno dello screen tearing.

Con HDMI 2.1 si potrà trarre vantaggio anche di frame rate più elevati per i video 4K e maggiori informazioni per la gestione precisa della retroilluminazione.

Pannelli LCD LED, QLED, OLED

I televisori che montano un pannello LCD retroilluminato a LED fanno ancora oggi la parte del leone. Molti di questi televisori possono illuminare dinamicamente porzioni specifiche dello schermo e oscurare altre parti per rappresentare al meglio anche aree che in una stessa scena presentano porzioni chiare e altre più scure.

La maggior parte dei TV LCD LED utilizza una cornice per la retroilluminazione posta sul bordo dello schermo. I TV LCD LED full-array usano diodi ad emissione di luce direttamente dietro lo schermo organizzati secondo una griglia che permette di illuminare o viceversa rendere scure le varie aree in maniera più puntuale.

La retroilluminazione full-array era un tempo prerogativa dei modelli di fascia alta ma con l’avvento di prodotti convincenti a prezzi sempre più bassi, questa caratteristica sta diventando sempre più comune anche sui dispositivi più economici.

Sempre più comune sta divenendo la tecnologia LCD quantum dots: in questo caso vengono utilizzate delle nanoparticelle, minuscoli cristalli che intervengono sul blu e permettono di ottenere una luce bianca pura.

I quantum dots offrono uno spettro di colori più ampio e una maggiore luminosità.

I Samsung QLED sono TV LCD quantum dots con retroilluminazione a LED.

Allo stato attuale i pannelli OLED superano i QLED sotto molti aspetti e soprattutto in quelli che contano di più nella realtà ma i QLED rappresentano una scelta intermedia più economica e alla portata di molti.

Nell’articolo QLED vs OLED: chi la spunta abbiamo provato a mettere a confronto i principali punti di forza di entrambe le soluzioni.

Da tenere d’occhio la tecnologia mini LED: Mini LED: cosa sono e quali le differenze rispetto ai micro LED.

Da parte nostra suggeriamo inoltre di ignorare completamente il dato relativo al rapporto di contrasto indicato dal produttore del televisore. I dati forniti dai vari produttori non sono direttamenti confrontabili tra loro.

Molto meglio verificare se il pannello è in grado di assicurare neri profondi e accertare la presenza di aloni, anche minimi, intorno agli oggetti resi con un elevato contrasto.

Infine, anche il televisore più costoso e ben realizzato ha un tallone d’Achille: l’esperienza sonora che può offrire è scarsa. Si tratta di una diretta conseguenza del design dei moderni televisori che porta all’estremo la riduzione degli spessori.

Non c’è più spazio per installare speaker in grado di produrre suoni pieni e ricchi. La soluzione? Non trascurare mai l’acquisto e l’installazione di una buona soundbar.

/https://www.ilsoftware.it/app/uploads/2026/01/Disney-offerta-3-mesi.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/Juventus-Benfica-streaming-gratis.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/Disney-nuova-offerta.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/HBO-Max-Prime-Video.jpg)