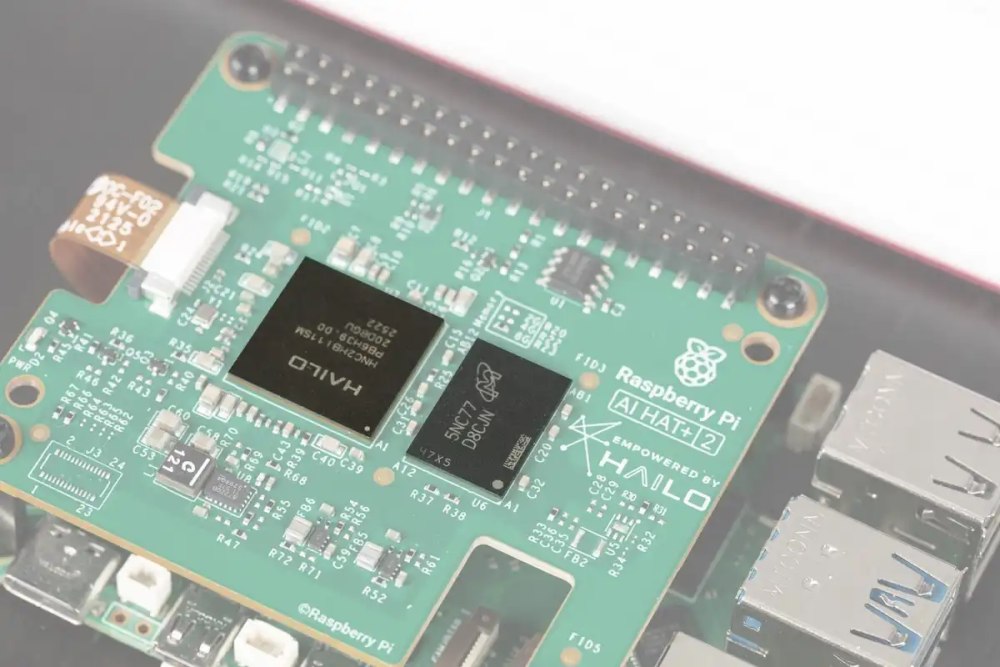

Il lancio del nuovo AI HAT+ 2 da 130 dollari da parte di Raspberry Pi ha attirato immediatamente l’attenzione della comunità maker ed embedded, soprattutto grazie alla presenza del nuovo acceleratore Hailo 10H e agli 8 GB di memoria LPDDR4X integrata. Sulla carta, il messaggio è chiaro: portare inferenza AI “vera” sulla scheda Raspberry Pi, scaricando la CPU e rendendo finalmente praticabile l’esecuzione locale di modelli AI, inclusi piccoli LLM, entro limiti di consumo estremamente contenuti.

A mettere alla prova queste promesse è stato, tra gli altri, Jeff Geerling, da anni uno dei riferimenti più autorevoli quando si parla di Raspberry Pi, hardware open e benchmark realistici. Nei suoi test approfonditi, condotti su un Raspberry Pi 5 con configurazioni comparabili tra CPU e NPU, Geerling ha analizzato senza filtri prestazioni, consumi e reali casi d’uso del nuovo AI HAT+ 2.

Raspberry Pi AI HAT+ 2: interessante sulla carta, limitato all’atto pratico

È proprio dalle prove sul campo che emerge un quadro più sfumato e, per certi versi, controintuitivo: AI HAT+ 2 (pagina di presentazione) è un prodotto tecnicamente interessante, efficiente dal punto di vista energetico e promettente per specifici scenari embedded, ma molto meno rivoluzionario di quanto possa sembrare a una prima lettura delle specifiche. In particolare, quando si parla di inferenza LLM e utilizzo quotidiano su Raspberry Pi, i limiti strutturali della piattaforma — a partire dalla memoria — diventano rapidamente evidenti.

Sulla carta il messaggio è forte: fino a 40 TOPS INT8 (il chip può eseguire fino a 40mila miliardi di operazioni al secondo utilizzando numeri interi a 8 bit), consumi massimi nell’ordine dei 3 W e la promessa di poter eseguire modelli di inferenza, inclusi LLM di piccole dimensioni, in modo autonomo. Nella pratica, però, l’impressione è quella di trovarsi di fronte a un prodotto ancora privo di una collocazione chiara, soprattutto per l’utente Raspberry Pi “reale”.

Chip Hailo 10H e limiti strutturali

Il chip Hailo 10H rappresenta un’evoluzione diretta rispetto agli acceleratori precedenti della stessa famiglia. È progettato per eccellere nell’inferenza a basso consumo, in particolare nell’ambito di workload legati alla visione artificiale e modelli ottimizzati INT8 e INT4. In questo contesto, l’architettura è estremamente efficiente: il rapporto prestazioni/watt è competitivo e superiore a quello della CPU della Raspberry Pi 5.

Tuttavia, gli 8 GB di RAM integrati nel modulo non sono espandibili e rappresentano un collo di bottiglia evidente per l’inferenza basata su LLM. Anche adottando modelli fortemente quantizzati, la memoria a disposizione offre poco margine per gestire finestre di contesto minimamente ampie.

Di contro, come conferma Geerling, la CPU della scheda Raspberry Pi 5, pur non essendo progettata per l’AI, resta sorprendentemente competitiva quando può spingersi fino ai suoi limiti di potenza, arrivando a consumare anche 10 W.

Inferenza LLM: quando la CPU batte la NPU

I test comparativi mostrano un dato che può sembrare controintuitivo: a parità di RAM (8 GB), la CPU della Raspberry Pi 5 supera spesso Hailo 10H in termini di throughput puro sull’inferenza LLM. La NPU (Neural Processing Unit) si dimostra più efficiente dal punto di vista energetico, ma non riesce a compensare il divario di potenza assoluta.

Solo su modelli molto specifici, come Qwen2.5 Coder 1.5B, Hailo riesce ad avvicinarsi alle prestazioni della CPU. Ciò avviene proprio perché modelli simili rientrano perfettamente nei limiti di memoria e sono ben adattati alla quantizzazione aggressiva. Appena si sale di scala, però, il vantaggio svanisce.

Il risultato è paradossale: se l’obiettivo è sperimentare seriamente con LLM locali, una Raspberry Pi 5 da 16 GB resta una scelta più flessibile ed efficace, anche se meno elegante dal punto di vista architetturale.

Il confronto impietoso con i modelli “grandi” su Raspberry Pi 16 GB

Un caso emblematico è quello del modello Qwen3 30B, reso utilizzabile su Raspberry Pi grazie a tecniche di compressione avanzate sviluppate da ByteShape. Ne avevamo parlato nel dettaglio in un altro nostro articolo, spiegando come la sfida sia proprio quella di portare modelli AI più pesanti su dispositivi come Raspberry Pi.

Con i test incentrati su Qwen3 30B, modello da 30 miliardi di parametri, si evince che nel caso di AI HAT 2+ non è la potenza di calcolo a mancare, ma proprio la RAM.

Su una Raspberry Pi 5 da 16 GB, pur con prestazioni modeste in termini di velocità, è possibile eseguire attività complesse di generazione di codice o sviluppare funzionalità articolate. È un approccio lento, ma sorprendentemente efficace. E soprattutto dimostra che, per l’inferenza LLM, la quantità di RAM resta il fattore determinante, molto più dell’accelerazione dedicata.

Visione artificiale: il vero punto di forza di AI HAT 2+ (ma non è una novità)

Dove l’AI HAT+ 2 mostra finalmente il suo valore è nella computer vision. L’elaborazione live di flussi video, con modelli come YOLO (You Only Look Once, famiglia di reti neurali progettata per la rilevazione di oggetti in tempo reale), avviene a frame rate elevati e con un’efficienza nettamente superiore rispetto alla CPU della Raspberry Pi.

Avvalendosi di un Camera Module 3, come emerge dagli esperimenti di Geerling, il sistema riconosce oggetti comuni in modo rapido e affidabile, arrivando a circa 30 fps senza difficoltà.

Tuttavia, anche qui emerge un problema di posizionamento: lo stesso risultato è già ottenibile con l’AI HAT originale o con la AI Camera, a costi inferiori. Il salto generazionale non è tale da giustificare automaticamente l’upgrade, soprattutto per chi utilizza Pi in progetti vision puri.

/https://www.ilsoftware.it/app/uploads/2026/01/raspberry-pi-AI-HAT-2-plus.jpg)

/https://www.ilsoftware.it/app/uploads/2026/03/memoria-claude-importazione-chatbot-ai.jpg)

/https://www.ilsoftware.it/app/uploads/2026/03/ai-windows-11-microslop.jpg)

/https://www.ilsoftware.it/app/uploads/2024/06/claude-35-sonnet-modello-generativo.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/copilot-integrato-esplora-file-windows-11.jpg)