Intel ha acquisito nel 2016 Nervana, società specializzata nelle soluzioni di intelligenza artificiale, e oggi la società di Santa Clara ha fornito le prime indicazioni sui nuovi prodotti figli di quell’importante investimento.

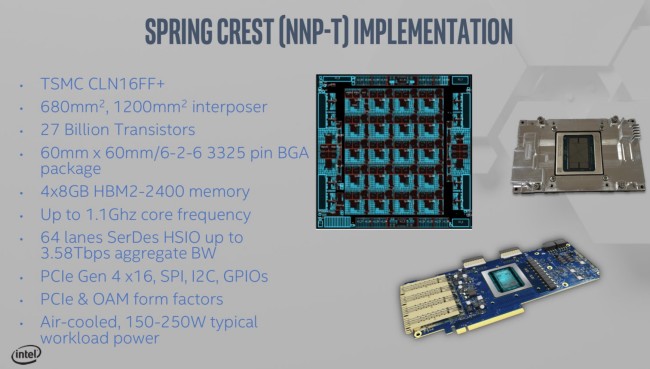

Si tratta di due processori neurali (NPP): NNP-T può essere utilizzato per la creazione di reti neurali mentre NNP-I per le inferenze. Il primo viene prodotto da TSMC ricorrendo a un processo a 16 nm mentre il seconda da Intel stessa, a 10 nm.

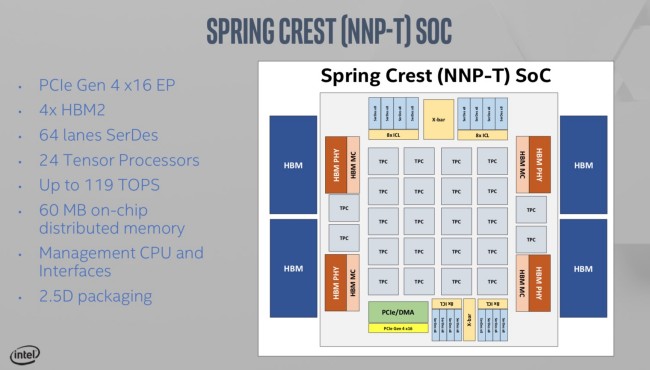

Il processore NNP-T offre connettività PCIe 4.0 x16 e include 32 GB di memoria HBM2 su quattro chip da 8 GB. Comprende un totale di 24 processori tensoriali ed è in grado di esprimere una potenza di calcolo pari a 119 TeraFLOPS (al suo interno 27 miliardi di transistor).

I chip principali hanno una dimensione di 680 mm2 mentre l’intermediario si occupa del collegamento alla memoria HBM2 ha una dimensione di 1200 mm2.

Il package misura 60 x 60 mm e i core lavorano a 1,1 GHz. Nel complesso, l’architettura mostrata da Intel è stata battezzata Spring Crest.

Il tensore è un’unità algebrica molto utilizzata nell’intelligenza artificiale con caratteristiche computazionali proprie. Il processore NNP-T di Intel è specializzato proprio nelle elaborazioni basate sull’utilizzo dei tensori; essendo basato su un’architettura fortemente scalabile, i carichi di lavoro possono essere distribuiti su più schede e su più macchine in modo tale da adattare l’hardware alle esigenze di ciascuna impresa.

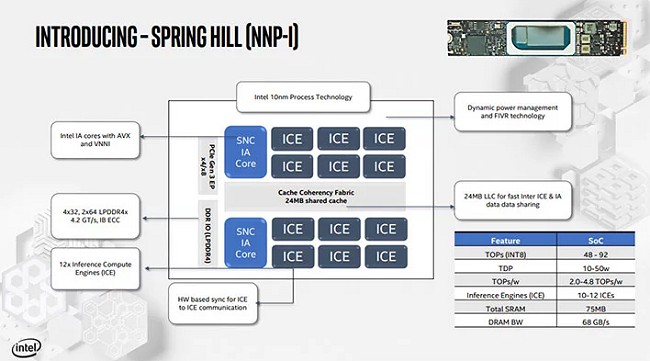

Con il nome in codice di Spring Hill, NNP-I è invece un SoC utilizzabile per la gestione delle inferenze: esso presenta una serie di core Ice Lake per accelerare l’implementazione del deep learning su vasta scala.

“Intel Nervana NNP-I offre un alto grado di programmabilità senza compromettere le prestazioni o l’efficienza energetica. Poiché l’intelligenza artificiale diventa pervasiva in ogni carico di lavoro, avere un acceleratore di inferenza dedicato facile da programmare, contraddistinto da latenze contenute, con il supporto per tutti i principali framework per il deep learning permette alle aziende di sfruttare appieno il potenziale dei loro dati“, si spiega da Intel.

Le soluzioni appena presentate da Intel sono particolarmente efficienti anche in ottica data center gestendo i carichi di lavoro al ritmo di 4,8 TOPs/W con il TDP che varia tra 10W e 50W.

Intel si trova ad affrontare una forte concorrenza nel campo delle soluzioni per l’intelligenza artificiale: basti pensare ai processori AWS Inferential di Amazon, alle Tensor Processing Unit di Google e al Deep Learning Accelerator (NVDLA) di Nvidia.

Le opportunità di mercato sono tuttavia enormi: nel 2017 i vertici di Intel avevano dichiarato che la sfida legata alle tecnologie per l’intelligenza artificiale sarebbe valsa 46 miliardi di dollari entro il 2020. Con i suoi processori Nervana NPP, Intel intende aggredire alcuni tra i mercati più proficui presentando soluzioni utilizzabili in ambito sanitario, automotive, nella ricerca e sui social media.

Maggiori informazioni possono essere reperite in questa presentazione (formato PDF).

/https://www.ilsoftware.it/app/uploads/2023/05/img_19790.jpg)

/https://www.ilsoftware.it/app/uploads/2025/07/Gemini_ImagetoVideo_Header_JW_op.width-2200.format-webp.jpg)

/https://www.ilsoftware.it/app/uploads/2025/07/wp_drafter_482871.jpg)

/https://www.ilsoftware.it/app/uploads/2025/07/grok-elon-musk.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/nate-ai-call-center-filippine.jpg)