/https://www.ilsoftware.it/app/uploads/2024/03/DBRX-databricks-modello.jpg)

Databricks, azienda leader nel fornire strumenti per l’analisi dei dati, ha annunciato il lancio di DBRX, un nuovo LLM (Large Language Model) aperto e rivolto al mercato generale.

DBRX è presentato come un modello rivoluzionario, accessibile e utilizzabile gratuitamente per scopi commerciali nei progetti con meno di 700 milioni di utenti attivi mensili.

L’innovativo DBRX, un nuovo modello linguistico di ultima generazione

Il modello DBRX di Databricks sfrutta un decoder basato su transformer e presenta un’architettura di tipo mixture-of-experts (MoE). Pur avendo un totale di 132 miliardi di parametri, soltanto 36 miliardi di essi sono attivi per ogni input, mentre i restanti parametri costituiscono “gli experts” attivati solo quando necessario. Grazie all’adozione dell’architettura MoE, è possibile ridurre le dimensioni, garantire un apprendimento e un’analisi altamente efficienti e migliorare le performance complessive.

A differenza di altri modelli come Mixtral (di Mistral AI) e Grok-1 (xAI di Elon Musk), che utilizzano anch’essi l’architettura MoE, DBRX dispone di 16 experts e ne attiva 4 per ogni input. Questa particolare configurazione ha portato a un miglioramento di ben 65 volte della qualità dei risultati forniti dal modello.

Gli ingegneri di Databricks hanno addestrato DBRX su un totale di 12.000 miliardi di token; la lunghezza massima della finestra di contesto è pari a 32.000 token. La robusta pipeline consente lo svolgimento di un ripetuto addestramento in maniera efficiente: chiunque può allenare da zero un modello di base MoE a pari livello rispetto a DBRX.

Le prestazioni del modello DBRX

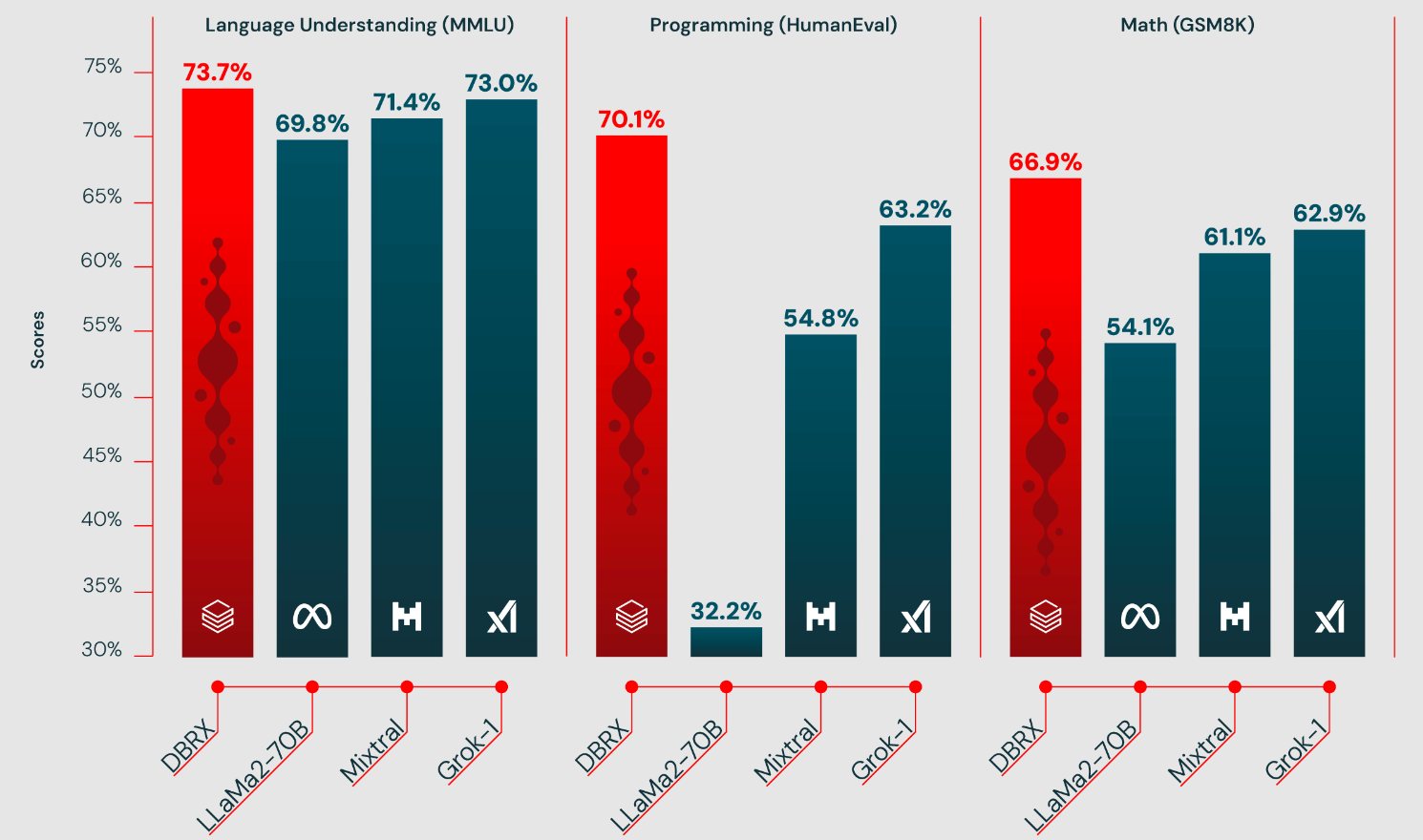

Secondo Databricks, i risultati dei benchmark svolti in vari ambiti (comprensione linguistica, sviluppo di codice, matematica) dimostrano che DBRX garantisce performance superiori rispetto a modelli come LLaMa2-70B, Mixtral e Grok-1.

Grazie all’utilizzo degli experts, DBRX può esprimere prestazioni generali davvero eccellenti, mantenendo al contempo elevate prestazioni in ambiti che richiedono abilità specializzate, come appunto la programmazione.

Un confronto con gli LLM proprietari (che non mostrano il codice sul quale basano il loro funzionamento), come GPT-3.5, GPT-4, Claude 3 Series, Gemini 1.0 Pro, Gemini 1.5 Pro e Mistral, evidenzia che DBRX si colloca a un livello paragonabile a Gemini 1.0 Pro e Mistral Medium.

Cos’è l’architettura mixture-of-experts (MoE)

L’architettura MoE offre un approccio innovativo nel caso dei modelli di intelligenza artificiale. L’architettura si distingue per la sua capacità di gestire una vasta gamma di input e di adattarsi dinamicamente alle esigenze del problema in esame.

Il concetto fondamentale dell’architettura MoE è quello di combinare l’output di più expert per arrivare all’elaborazione di una predizione finale. Ogni expert è una sottorete specializzata (rete neurale specializzata) in un particolare aspetto del problema.

In un modello di linguaggio come DBRX, sono previsti expert specializzati nella comprensione del contesto grammaticale, nell’analisi semantica e nella generazione di testo coerente.

La rete di selezione, detta anche gate network, è responsabile di determinare quali expert devono essere attivati per un dato input. Questa rete prende in input il dato grezzo e produce un vettore di pesi che indica la probabilità di attivazione di ciascun expert.

Dopo l’attivazione degli expert, i rispettivi output sono combinati per produrre la previsione finale. Questa combinazione può essere ponderata in base ai pesi assegnati dalla rete di selezione o può essere una semplice “media” dei loro output.

Licenza e utilizzo

Sia il modello base, DBRX Base, che il modello ottimizzato DBRX Instruct, sono distribuiti con una licenza aperta su Hugging Face e possono essere facilmente utilizzati tramite le API Databricks Foundation Model.

Con il lancio di DBRX, Databricks si conferma all’avanguardia nell’innovazione dei modelli linguistici su larga scala. La combinazione di un’architettura MoE avanzata, la vasta quantità di dati di addestramento e la distribuzione open source promette di rivoluzionare l’analisi dei dati e l’elaborazione del linguaggio naturale in diversi settori industriali.

Per maggiori informazioni, è possibile fare riferimento al post pubblicato sul sito ufficiale di Databricks.

/https://www.ilsoftware.it/app/uploads/2025/07/gpt-5-openai.jpg)

/https://www.ilsoftware.it/app/uploads/2025/07/video-dissing-ai-mcdonalds-popeyes.jpg)

/https://www.ilsoftware.it/app/uploads/2024/05/plugin-openvino-intelligenza-artificiale-generativa-GIMP.jpg)

/https://www.ilsoftware.it/app/uploads/2024/10/spirit-lm-meta-risposte-vocali-espressive.jpg)