Parlando di affidabilità e durata delle unità SSD, soprattutto in ambiente Windows, circolano da anni consigli contrastanti, spesso presentati con toni allarmistici. Video e guide promettono di “salvare” gli SSD riducendo le scritture del sistema operativo, evocando scenari in cui Windows agirebbe come un agente di degrado continuo. Una lettura più attenta, però, impone di separare le ottimizzazioni tecniche effettivamente utili da quelle che oggi risultano marginali o addirittura controproducenti.

Per comprendere davvero il tema bisogna partire da un dato importante: gli SSD hanno sì un limite di scritture, espresso in TBW (Total Bytes Written). Anche se la formula per stimare la durata delle unità è da prendere con il beneficio d’inventario. Nelle unità SSD moderne il valore assicura anni di utilizzo intenso. Per un utente standard o anche avanzato, il raggiungimento del limite di usura coincide quasi sempre con la fine del ciclo di vita del computer stesso. L’idea di un “killer silenzioso” che consuma rapidamente le unità SSD appartiene più alla retorica comunicativa che alla realtà tecnica.

SSD: da TBW teorico a valori reali

I produttori indicano per ogni SSD un valore di durabilità, espresso in TBW o in DWPD (Drive Writes Per Day). Questi numeri rappresentano una garanzia conservativa, non il punto in cui l’unità smette improvvisamente di funzionare. Nei test reali, però, si è visto qualcosa di sorprendente: molti SSD continuavano a funzionare ben oltre il valore TBW dichiarato, arrivando a scrivere quantità enormi di dati.

Per questo motivo, già da molti anni orsono si è iniziato a parlare di “petabyte club” per riferirsi ai tanti modelli consumer che a fronte di 70-100 TBW dichiarati hanno superato, in molti casi, i 1.000 TB (1 Petabyte) o 2.000 TB (2 Petabyte) di dati scritti nell’intero ciclo di vita.

Perché gli SSD resistono così tanto

Questo risultato non è casuale, ma dipende da diverse caratteristiche progettuali (in un altro articolo abbiamo visto le tecnologie che rendono gli SSD più veloci ma anche più duraturi):

- Wear leveling avanzato. Il controller dell’SSD distribuisce le scritture su tutte le celle disponibili, evitando che alcune si usurino prematuramente.

- Over-provisioning. Una parte della memoria interna non è visibile all’utente ed è utilizzata come riserva per sostituire le celle degradate.

- Error correction (ECC). Gli SSD integrano sistemi di correzione errori sempre più sofisticati, che permettono di continuare a leggere dati correttamente anche quando le celle iniziano a degradarsi.

- Margini conservativi dei produttori. I valori TBW sono volutamente prudenti per garantire affidabilità nel periodo di garanzia e limitare il rischio per il produttore.

Fattori che incidono davvero sulla durata di un SSD

Le operazioni di scrittura sono certamente un fattore di usura intrinseco degli SSD, ma nel contesto reale dei sistemi moderni è raramente la causa principale di guasto. La percezione che “scrivere dati = usurare rapidamente l’unità” deriva dalle prime generazioni di NAND flash e da una comprensione parziale di come funzionano gli SSD contemporanei. Ma, allora, quali sono i fattori che incidono maggiormente?

I 5 aspetti da tenere d’occhio

- Qualità del controller e del firmware. Il vero “cervello” dell’SSD è il controller. Un controller di bassa qualità o con firmware instabile può causare corruzione dei dati, brick improvvisi dell’unità, perdita di mapping della memoria. Storicamente, molti guasti di SSD non sono stati causati da celle esaurite, ma da problemi firmware o controller difettosi.

- Temperatura operativa. Il calore è uno dei fattori più critici. Temperature elevate e prolungate possono accelerare il degrado delle celle NAND, ridurre la ritenzione dei dati, stressare i componenti elettronici del controller. Gli SSD NVMe, soprattutto in slot M.2 senza dissipazione, possono facilmente superare i 70°C sotto carico. Nel lungo periodo, questo ha un impatto reale sulla durata.

- Qualità della NAND (SLC, MLC, TLC, QLC). Non tutte le memorie flash sono uguali.

SLC: altissima resistenza (rarissima in ambito consumer)

MLC: buona resistenza

TLC: compromesso comune

QLC: più economica ma con minore durata per cella

Le unità SSD consumer moderni usano spesso TLC o QLC, compensando con algoritmi e riserve di celle. Tuttavia, a parità di condizioni, la NAND di qualità superiore resiste più a lungo. - Tempo e conservazione dei dati (data retention). È uno dei fattori più importanti ma ancora troppo sottovalutati. Anche senza scritture, le celle NAND perdono carica nel tempo. Con l’invecchiamento dell’unità. La capacità di mantenere i dati senza alimentazione diminuisce e aumenta il rischio di errori di lettura su dati vecchi. Ecco il perché della morte improvvisa di unità SSD che hanno diversi anni sulle spalle, anche senza alcuna avvisaglia da parte del sistema SMART.

- Stato di riempimento del disco. Un SSD quasi pieno lavora peggio: il controller ha meno spazio per il wear leveling; aumenta la write amplification; diminuisce l’efficienza della garbage collection. Mantenere uno spazio libero (idealmente 10–20%) aiuta concretamente a ridurre l’usura nel lungo periodo.

- Alimentazione elettrica e stabilità. Picchi di tensione, alimentatori scadenti o spegnimenti improvvisi possono causare corruzione della mappa interna dei dati, danneggiare il controller e provocare perdita di dati in cache. Gli SSD di fascia alta includono condensatori di protezione (power loss protection), ma quelli consumer spesso no.

- Carichi di lavoro anomali. Non tutte le scritture sono uguali. Un uso domestico genera scritture moderate e distribuite. Al contrario, alcuni scenari possono stressare molto l’unità: database ad alta intensità di I/O; video editing 4K/8K con cache pesanti; macchine virtuali multiple; sistemi di logging intensivo.

SSD e Windows: tra ottimizzazione reale e miti tecnici

Una delle prime raccomandazioni spesso proposte è la disattivazione dell’indicizzazione di Windows. Il sistema mantiene un database aggiornato dei file per rendere istantanea la ricerca, scrivendo dati in modo continuo ma leggero sull’unità.

Da un punto di vista strettamente tecnico è vero che si tratta di scritture aggiuntive. Tuttavia, l’impatto reale sul ciclo di vita di un SSD moderno è trascurabile. Il costo, invece, in termini di esperienza utente è elevato: senza indicizzazione, la ricerca diventa lenta, talvolta inutilizzabile in contesti professionali con molti file.

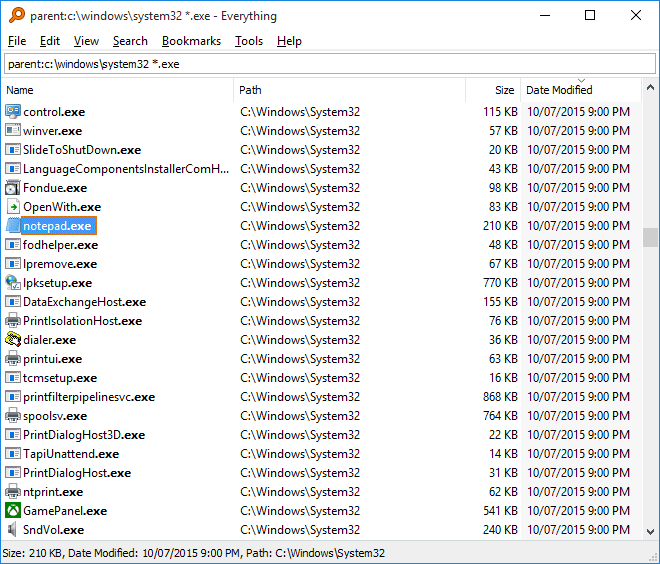

La disattivazione può avere senso solo in casi molto specifici, ad esempio su sistemi dedicati a compiti ristretti o quando si utilizzano strumenti alternativi estremamente ottimizzati come Everything. In tutti gli altri scenari, la perdita di efficienza operativa supera di gran lunga il beneficio teorico.

È vero: anche Everything mantiene un indice. Ma il modo in cui lo costruisce e lo aggiorna è radicalmente diverso rispetto all’indicizzazione classica di Windows. Everything sfrutta direttamente la MFT (Master File Table) del file system NTFS. Non indicizza il contenuto dei file, ma solo nomi e metadati: costruisce l’indice leggendo strutture già presenti nel file system e aggiorna l’indice intercettando in tempo reale le modifiche al file system. Per questo, con Everything, le operazioni di scrittura sono sempre minime.

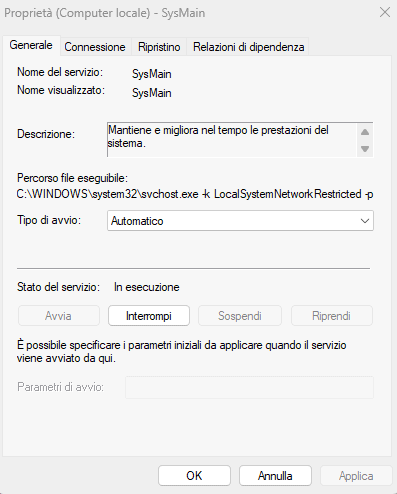

SysMain (Superfetch): una tecnologia evoluta che si adatta agli SSD

Il servizio di sistema SysMain (si può digitare subito sc query sysmain per verificare se è regolarmente in esecuzione) noto in passato come Superfetch, analizza il comportamento dell’utente per precaricare in memoria le applicazioni più utilizzate. In epoca di hard disk meccanici era una funzione determinante per ridurre i tempi di accesso. Con gli SSD, il vantaggio percepito è minore.

Windows 10 e Windows 11, però, gestiscono automaticamente questo servizio adattandolo alla presenza di un SSD. Le scritture generate sono minime e fanno parte di un bilanciamento già ottimizzato dal sistema operativo. Disabilitarlo non provoca danni, ma il beneficio concreto in termini di riduzione dell’usura è irrilevante rispetto alla capacità totale del disco.

In altre parole, si tratta di una modifica tecnicamente lecita ma sostanzialmente inutile nella maggior parte dei contesti reali.

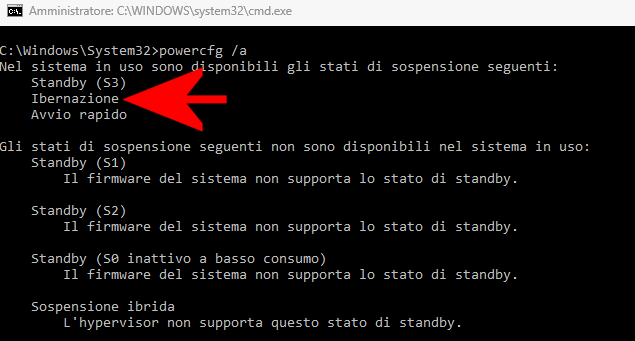

Ibernazione: una scelta pratica più che una misura di protezione

Diverso è il discorso per l’ibernazione. Quando attiva, e su richiesta dell’utente, Windows salva l’intero contenuto della RAM su disco nel file hiberfil.sys. Su sistemi con molta memoria, questo significa scrivere decine di gigabyte ogni volta che si utilizza questa modalità.

Disabilitare l’ibernazione non è tanto una strategia per “salvare” l’SSD, quanto una scelta funzionale: si recupera spazio prezioso sul disco, spesso nell’ordine di diversi gigabyte. Per chi utilizza un desktop o non ha bisogno di questa modalità, la disattivazione è sensata e priva di controindicazioni.

Da parte nostra, comunque, continuiamo a utilizzare l’ibernazione (almeno sui PC desktop) con grande soddisfazione anche nel 2026. Tra l’altro, Windows 11 la disattiva per default tanto che non è disponibile nel menu Start (chi la vuole usare deve abilitarla manualmente).

Ad ogni modo, è possibile attivare o disattivare l’ibernazione in Windows 10 e Windows 11 molto semplicemente usando i comandi powercfg /hibernate on e powercfg /hibernate off da una finestra del terminale.

Con il comando powercfg /a si possono verificare gli stati di sospensione disponibili e attivati, tra cui l’ibernazione.

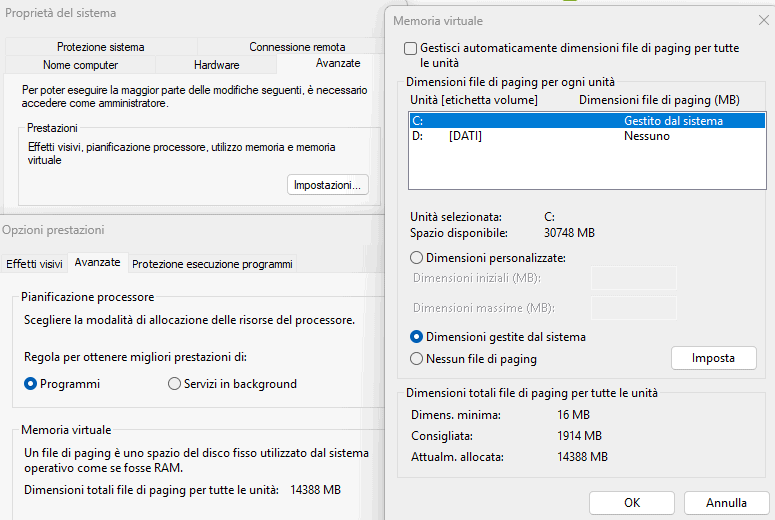

File di paging: perché toccarlo può peggiorare tutto

La gestione della memoria virtuale è uno dei punti più fraintesi. Il file di paging serve a gestire situazioni in cui la RAM non è sufficiente, permettendo al sistema di evitare crash e instabilità.

Ridurne le dimensioni o spostarlo su un disco meccanico per “proteggere” l’SSD è un approccio che può avere effetti negativi evidenti. Nel momento in cui la memoria RAM si satura, il sistema diventerebbe estremamente lento, oppure alcune applicazioni smetterebbero di funzionare correttamente.

Le scritture generate dal paging sono fisiologiche e già previste nel ciclo di vita dell’SSD. Intervenire manualmente senza una reale necessità introduce più problemi che benefici.

Oltretutto, le situazioni in cui la memoria RAM disponibile si esaurisce, sono molto più frequenti di quello che si immagini. Gli utenti avanzati lo sanno bene, anche chi dispone di 16 GB o 32 GB di RAM sul proprio sistema. L’abbiamo spiegato nel dettaglio presentando un software come RAMMap.

TRIM e gestione corretta dell’unità: la vera manutenzione

Se c’è un elemento davvero centrale nella gestione degli SSD è il comando TRIM. Questa funzione consente al sistema operativo di comunicare all’unità quali blocchi di dati non sono più utilizzati, permettendo al controller interno di gestire al meglio le celle di memoria e mantenere elevate le prestazioni nel tempo.

Verificare che TRIM sia attivo è una pratica corretta e consigliata. Allo stesso modo, è importante che Windows riconosca correttamente il disco come SSD per evitare operazioni non appropriate, come la deframmentazione tradizionale.

Basta aprire il prompt dei comandi come amministratore e digitare:

fsutil behavior query DisableDeleteNotify

Il valore 0 indica che TRIM è attivo (nel caso in cui fosse a 1, si può attivarlo con fsutil behavior set DisableDeleteNotify 0).

Nella pratica, su Windows 10 e Windows 11, TRIM è attivo di default, ma la verifica richiede pochi secondi ed è sempre buona norma effettuarla.

Suggeriamo inoltre di digitare Deframmenta e ottimizza unità nella casella di ricerca di Windows: nella colonna Tipo di supporto deve comparire Unità a stato solido (SSD) per le unità di questo genere. Significa che Windows ha correttamente rilevato la tipologia dell’unità di memorizzazione e sta già applicando le ottimizzazioni necessarie. Ne parlava Scott Hanselman già nel 2014 e ne abbiamo parlato noi nell’articolo su come ottimizzare SSD in Windows.

Log di sistema e registro eventi: la vera sorgente di scritture costanti

Ci siamo accorti che i consigli “generalisti” che si prefiggono di aiutare gli utenti a preservare la vita delle unità SSD, tra l’altro, mancano sempre di riferimento ai log di sistema e al registro degli eventi.

Su qualsiasi sistema operativo moderno, Windows compreso, esistono numerose fonti di scrittura continua:

- Event Viewer (registro eventi)

- Log di sistema e applicativi

- Cache varie (browser, update, telemetria)

- File temporanei

Queste scritture sono costanti e fanno parte del funzionamento normale del sistema. Se si parla di indicizzazione, si dovrebbe allora parlare anche di queste attività di scrittura che però rientrano perfettamente, a loro volta, nei cicli di scrittura previsti dal produttore dell’SSD. Il loro impatto sull’usura complessiva di un SSD moderno è comunque trascurabile nel ciclo di vita reale.

Il caso Linux e microSD: perché su Raspberry Pi il problema è reale

Su Raspberry Pi e sistemi embedded la situazione è diversa per diversi motivi: le schede microSD hanno una resistenza molto inferiore rispetto agli SSD e i sistemi Linux generano molti log (syslog, journald, ecc.).

In questo contesto, spostare i log su ramdisk (tmpfs) è davvero una pratica sensata (altro che disattivare l’indicizzazione di Windows o SysMon) perché l’operazione riduce drasticamente le scritture permanenti, evita il degrado precoce della memoria flash, migliora le prestazioni I/O.

In questo caso l’ottimizzazione è davvero concreta e con un impatto reale sulla durata del supporto.

Trasportare questa logica su un PC con SSD moderno è un errore concettuale per tutto quanto osservato in precedenza (TBW, controller con wear leveling avanzato, cache DRAM e algoritmi di gestione interna). Inoltre, le scritture generate da log, indicizzazione e servizi di sistema rappresentano una frazione minima del volume complessivo.

Ottimizzazione di un’unità SSD per uso server su Linux

Quando si passa da un uso desktop a un impiego su server 24/7, l’unità SSD smette di essere un semplice dispositivo di storage e diventa un componente critico soggetto a un carico di scritture continuo e spesso sottovalutato.

Per ottenere un’estensione reale della vita operativa non basta ridurre genericamente le scritture: serve intervenire in modo mirato su file system, kernel, servizi di sistema e applicazioni.

Su Linux si può innanzi tutto attivare il TRIM periodico con systemctl enable fstrim.timer, lasciando almeno 10–15% di spazio non partizionato per over-provisioning.

Per capire quanto si sta realmente “consumando” l’SSD si possono osservare parametri SMART e contatori di scrittura. Gli indicatori più rilevanti sono:

- TBW (Total Bytes Written) dichiarato dal produttore

- Data Units Written (NVMe SMART log)

- Wear Leveling Count / Percentage Used

- Media and Data Integrity Errors

Questi dati sono recuperabili avvalendosi dei seguenti comandi:

smartctl -a /dev/sdX (pacchetto smartmontools)

nvme smart-log /dev/nvme0 (pacchetto nvme-cli)

Un esempio concreto: un SSD NVMe consumer da 1 TB con TBW dichiarato di 600 TB può sostenere circa 164 GB/giorno per 10 anni. Se il server scrive 300–400 GB al giorno tra log, database e cache, l’usura in 3 anni è perfettamente coerente.

File system e opzioni di mount su Linux

La scelta del file system ha un impatto concreto sulla write amplification. File system progettati per flash come F2FS tendono a ridurre le riscritture inutili, mentre soluzioni come ZFS, se non configurate con attenzione, possono generare una mole di scritture molto superiore.

Anche con file system tradizionali come ext4, la scelta delle opzioni di mount, cioè dei parametri con cui il sistema monta e gestisce il disco, incide molto sulle prestazioni: per esempio l’opzione noatime impedisce l’aggiornamento continuo dei metadati (le informazioni sul file, come la data di ultimo accesso) a ogni lettura, riducendo le operazioni di scrittura; inoltre parametri come commit=, che definiscono ogni quanti secondi i dati in memoria vengono scritti fisicamente su disco (flush), possono essere aumentati per diminuire la frequenza di queste scritture, con il rovescio della medaglia di una finestra più ampia in cui, in caso di crash, una parte dei dati recenti potrebbe andare persa.

Impostazioni più efficaci

» ext4 (configurazione bilanciata). Montaggio tipico in /etc/fstab:

UUID=xxxx / ext4 defaults,noatime,commit=60,discard 0 1

noatime elimina scritture di accesso

commit=60 riduce i flush (dal default di 5 secondi a 60 secondi)

discard abilita TRIM online (alternativa: fstrim periodico)

» F2FS (Flash-Friendly File System). È particolarmente adatto per workload con molte scritture random:

mkfs.f2fs /dev/sdX

mount -t f2fs -o noatime,compress_algorithm=lz4 /dev/sdX /data

Supporta compressione trasparente (LZ4/ZSTD) riducendo i dati scritti.

» Btrfs con compressione. La compressione riduce write amplification in scenari con file ripetitivi (log, JSON, dump).

mount -o compress=zstd:3,noatime,ssd /dev/sdX /data

» ZFS. Sconsigliato su SSD consumer in ambienti ad alta scrittura senza tuning aggressivo (ARC, SLOG, recordsize), perché aumenta le scritture.

Linux: come ridurre le scritture superflue

In un server domestico o di laboratorio, gran parte delle scritture deriva da componenti non essenziali.

I log di sistema sono tra i principali responsabili. Spostarli in RAM (ad esempio tramite tmpfs o soluzioni come log2ram) o inviarli a un altro nodo riduce drasticamente le scritture. Lo stesso vale per cache applicative, file temporanei e directory come /tmp.

Per spostare i log systemd-journald in RAM si può impostare il file /etc/systemd/journald.conf come segue:

Storage=volatile

RuntimeMaxUse=200M

SystemMaxUse=0

Così i log restano in RAM.

In alternativa, come accennato in precedenza, si può installare log2ram: l’applicazione mantiene /var/log in RAM e sincronizza periodicamente su SSD.

È possibile anche montare in RAM le directory temporanee:

tmpfs /tmp tmpfs defaults,noatime,nosuid,size=1G 0 0

tmpfs /var/tmp tmpfs defaults,noatime,nosuid,size=512M 0 0

Lo swap su SSD è un tema discusso: con sistemi moderni e quantità adeguate di RAM è spesso possibile evitarlo del tutto oppure sostituirlo con zram, riducendo l’I/O sull’unità SSD.

Anche aggiornamenti di sistema molto frequenti o workload di compilazione continua generano scritture consistenti: per server stabili è preferibile usare distribuzioni LTS (Long Term Support) e ridurre operazioni inutili di rebuild.

Applicazioni ad alto impatto di scrittura

Alcuni servizi generano quantità enormi di operazioni I/O. Si pensi a database (MySQL/MariaDB, PostgreSQL), stack di logging (Elasticsearch, Loki), container runtime (Docker, containerd), gestione video NVR (Frigate, ZoneMinder).

Sia con MariaDB / MySQL che con PostgreSQL si possono definire parametri di configurazione che riducono flush sincroni mentre con Docker si possono ridurre i log dei container.

Ottimizzazioni reali degli SSD su Windows: desktop e server

Se si vuole parlare di ottimizzazione concreta degli SSD in ambiente Windows, è necessario uscire dalla logica dei “tweak universali” e distinguere chiaramente tra uso desktop e uso server.

Nel primo caso, le scritture generate dal sistema operativo sono già ampiamente compatibili con i limiti di durabilità delle unità moderne; nel secondo, invece, sono i carichi applicativi – database, virtualizzazione, logging continuo – a determinare realmente l’usura.

Su un PC desktop, gli interventi realmente sensati sono pochi e mirati. Il primo, come spiegato in precedenza, è verificare che TRIM sia attivo e funzionante; il secondo è mantenere sempre una quota di spazio libero sull’unità (almeno il 10–20%); il terzo è monitorare periodicamente lo stato SMART dell’unità con strumenti come CrystalDiskInfo o i tool ufficiali dei produttori (Samsung Magician, WD Dashboard, Kingston SSD Manager).

Gestione dei carichi di scrittura nei sistemi Windows server

Il quadro cambia in modo significativo su Windows Server o sistemi desktop usati come server 24/7. Qui la fonte principale di scritture non è Windows in sé, ma i servizi applicativi.

In presenza di IIS, SQL Server, Hyper-V, sistemi di logging o container Docker/Podman, il volume di I/O può diventare molto elevato e incidere realmente sulla vita dell’SSD. In questi scenari, le ottimizzazioni efficaci non consistono nel disabilitare servizi generici, ma nel gestire in modo consapevole i flussi di scrittura.

Un primo intervento concreto riguarda i log applicativi. IIS, ad esempio, per impostazione predefinita genera file di log continui nella directory \inetpub\logs\LogFiles: è buona pratica limitarne i campi, impostare una rotazione giornaliera e, nei sistemi sottoposti a lavoro intenso, spostarli su un disco secondario o su storage di rete.

Lo stesso principio vale per SQL Server, dove l’impostazione di modelli di recovery adeguati e la gestione delle dimensioni dei file di log consente di ridurre scritture inutili. In ambienti con macchine virtuali, inoltre, l’uso di file VHDX a dimensione fissa riduce la frammentazione e le scritture rispetto alle unità dinamiche.

Separazione dello storage, caching e fattori fisici

Un secondo intervento riguarda la separazione dei carichi: mantenere il sistema operativo su un SSD e spostare database, macchine virtuali o cache su un secondo SSD – oppure su storage differente – è una pratica molto più efficace di qualsiasi tweak di sistema. Non perché riduca le scritture complessive, ma perché evita che il disco di sistema sia sottoposto a carichi intensivi e distribuisce l’usura su più unità.

Un terzo ambito di ottimizzazione reale è la gestione della memoria e delle cache. Nei server con molta RAM, l’uso di cache in memoria (ad esempio con Redis, caching applicativo o RAM disk per file temporanei) riduce il numero di scritture persistenti.

Allo stesso modo, limitare la crescita incontrollata dei log di applicazioni e container – ad esempio configurando la rotazione dei log Docker o dei servizi Windows – ha un impatto concreto e misurabile nel tempo.

Infine, non va trascurato l’aspetto fisico: temperatura e alimentazione incidono sulla durata più di molte ottimizzazioni software. SSD NVMe montati in slot M.2 senza dissipazione, specialmente in chassis compatti o laptop usati come server, possono lavorare stabilmente sopra i 70°C. In questi casi, un semplice dissipatore o un miglioramento della ventilazione ha un effetto reale sulla longevità dell’unità, così come l’uso di alimentatori stabili e, nei server critici, di gruppi di continuità (UPS) per evitare spegnimenti improvvisi.

/https://www.ilsoftware.it/app/uploads/2026/02/estendere-durata-ssd-windows-linux.jpg)

/https://www.ilsoftware.it/app/uploads/2026/02/linus-torvalds-rigetta-patch-MMC-kernel-linux.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/wayland-linux-2026.jpg)

/https://www.ilsoftware.it/app/uploads/2026/02/eagle-software-windows-su-linux.jpg)

/https://www.ilsoftware.it/app/uploads/2026/02/sudo-sviluppatore-chiede-aiuto.jpg)