Il calcolo quantistico rappresenta una delle frontiere più ambiziose della scienza e dell’ingegneria moderna. L’obiettivo dell’industria quantistica non è semplicemente costruire macchine più potenti, ma sviluppare sistemi capaci di risolvere problemi di scala industriale e scientifica irrisolvibili con i computer classici. Gli sviluppi degli ultimi anni nel campo dei computer quantistici stanno gettando le basi per un futuro in cui il quantum computing potrebbe trasformare radicalmente settori come la chimica computazionale, la simulazione di materiali e l’intelligenza artificiale.

I tre livelli del calcolo quantistico

Microsoft Quantum ha proposto un framework per valutare i progressi nel settore, distinguendo tre livelli di sofisticazione delle macchine quantistiche:

- NISQ (Noisy Intermediate-Scale Quantum): sono i computer quantistici attuali, composti da circa 1.000 qubit, caratterizzati da elevata rumorosità e suscettibilità agli errori.

- Macchine a piccola scala con correzione degli errori: queste implementano protocolli robusti per individuare e correggere errori nei qubit, rappresentando il passaggio critico verso sistemi affidabili.

- Macchine su larga scala: sistemi con centinaia di migliaia fino a milioni di qubit, in grado di eseguire milioni di operazioni quantistiche con alta fedeltà, destinati ad apportare e propri vantaggi scientifici e industriali.

Il 2026 sarà un anno cruciale: Microsoft e QuEra prevedono di rendere disponibili i primi computer quantistici di livello due ai clienti, segnando l’inizio dell’era della computazione quantistica affidabile.

L’importanza della correzione degli errori

Il principale limite dei sistemi attuali è la loro vulnerabilità al rumore, dovuta alla fragilità intrinseca dei qubit. Diversamente dai bit classici, che possono essere ripetuti per ridurre gli errori, i qubit non possono essere copiati. La soluzione risiede nell’uso dei qubit logici, che codificano l’informazione di un singolo qubit su più qubit fisici, permettendo algoritmi di correzione degli errori di recuperare i dati originali nonostante le perturbazioni.

Esperimenti recenti condotti da QuEra, in collaborazione con Harvard, MIT e University of Maryland, e successivamente da Microsoft e Atom Computing, hanno dimostrato che i qubit logici riducono significativamente il tasso di errore, confermando la validità del concetto nella pratica.

I primi computer commerciali con qubit logici operativi, come la macchina Magne di Microsoft (50 qubit logici su 1.200 qubit fisici) e il sistema di QuEra (37 qubit logici su 260 fisici), saranno disponibili tra il 2026 e il 2027.

Qubit ad atomi neutri

Una caratteristica distintiva delle prime macchine di livello due è l’uso dei qubit ad atomi neutri. A differenza dei qubit superconduttori o fotonici, gli atomi neutri possono essere spostati e manipolati in array 2D o 3D tramite laser, permettendo l’implementazione di tecniche di correzione degli errori altrimenti impossibili.

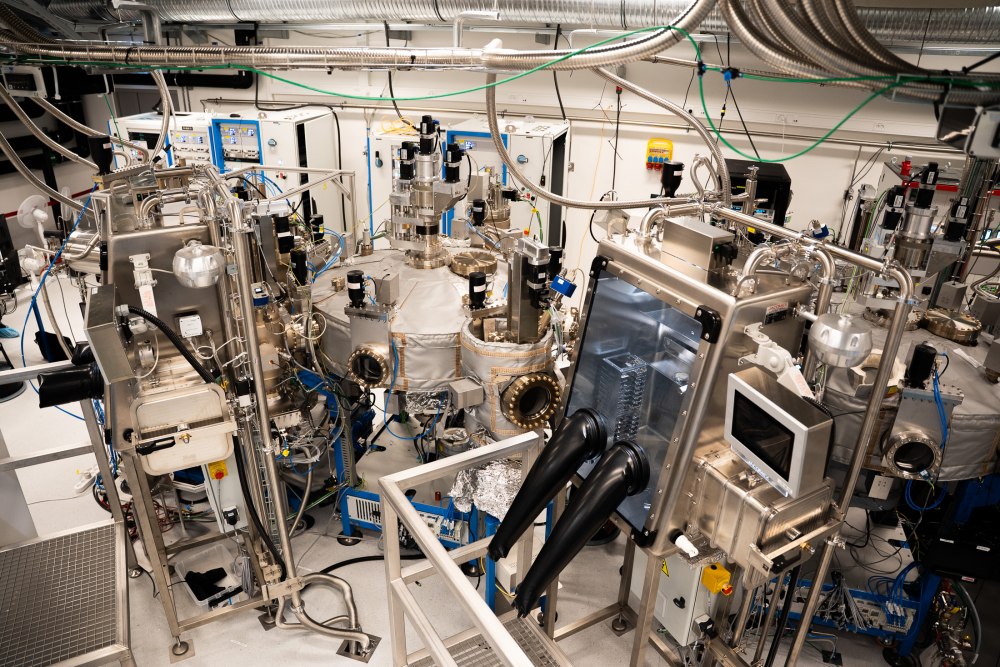

All’interno di camere a vuoto, un gas di atomi è raffreddato vicino allo zero assoluto e manipolato con precisione attraverso pinzette ottiche. Ogni atomo costituisce un qubit fisico e le operazioni quantistiche sono effettuate tramite sequenze di laser che agiscono in parallelo su più qubit, aumentando l’efficienza computazionale nonostante la velocità intrinsecamente inferiore rispetto ai qubit superconduttori.

Visioni contrapposte e scalabilità

Non tutti nel settore condividono il framework a tre livelli di Microsoft. IBM, ad esempio, suggerisce un approccio più orientato all’utilità pratica dei circuiti quantistici esistenti, combinando strategie di soppressione degli errori con lo sviluppo graduale verso macchine completamente corrette. Big Blue suggerisce di calcare un percorso incrementale, guidato dall’utilità computazionale, piuttosto che procedere con un salto diretto verso sistemi con correzione completa degli errori su larga scala. È una filosofia diversa da quella che punta a implementare fin da subito qubit logici pienamente protetti.

Tuttavia, le potenzialità degli atomi neutri in termini di scalabilità sono notevoli. Entrambi i team di QuEra e Atom Computing prevedono di riuscire a inserire fino a 100.000 atomi in una singola camera a vuoto nei prossimi anni, tracciando una roadmap chiara verso macchine di livello tre, capaci di realizzare calcoli fino a oggi impensabili.

I numeri critici del calcolo quantistico: soglie, overhead e tempo di soluzione

Al di là delle roadmap industriali, il progresso reale del calcolo quantistico è vincolato da pochi parametri quantitativi fondamentali.

Le architetture fault-tolerant si basano su soglie di errore ben definite: per i codici di superficie, oggi considerati lo standard di riferimento, la soglia teorica di fault tolerance si colloca intorno a 1×10⁻², ma un vantaggio computazionale concreto richiede errori di porta inferiori a 10⁻³ ed errori di misura prossimi a 10⁻⁴.

Al di sopra di questi valori, l’overhead della correzione degli errori cresce rapidamente, rendendo inefficiente la codifica logica. In termini pratici, un singolo qubit logico affidabile richiede tra 100 e 1.000 qubit fisici, a seconda di vari parametri anche legati all’hardware in uso. Il rapporto si amplifica su scala algoritmica: applicazioni realistiche in chimica quantistica, ottimizzazione o simulazione di materiali necessitano di 1.000–10.000 qubit logici, equivalenti a 10⁵–10⁷ qubit fisici, ben oltre le capacità attuali.

A questi vincoli strutturali si aggiunge il fattore temporale, spesso riassunto nel concetto di time to solution, che dipende non solo dalla velocità delle singole porte ma dalla profondità totale del circuito, dal numero di cicli di correzione e dal grado di parallelismo. I qubit superconduttori operano con gate dell’ordine di 10–50 ns, mentre i sistemi a atomi neutri utilizzano operazioni più lente, tipicamente 1–10 µs, compensate però da un parallelismo massivo e da un minor numero di cicli di correzione. Il risultato è che la prestazione reale non è determinata da un singolo parametro, ma dall’equilibrio tra rumore, overhead e tempo complessivo necessario per ottenere un risultato fisicamente affidabile.

Codici di superficie: cosa sono e perché sono centrali

I codici di superficie (surface codes) sono una classe di codici di correzione degli errori quantistici topologici in cui l’informazione di un qubit logico è distribuita su una griglia bidimensionale di qubit fisici, tipicamente disposti su un reticolo regolare.

Con questo schema, gli errori non sono corretti direttamente sullo stato quantistico, ma rilevati indirettamente attraverso misure ripetute di operatori locali (detti stabilizzatori) che identificano la presenza e la posizione degli errori senza distruggere l’informazione codificata. Il principale vantaggio dei codici di superficie è la loro elevata tolleranza al rumore e il fatto che richiedono solo interazioni locali tra qubit adiacenti, una caratteristica compatibile con molte architetture hardware reali.

Il rovescio della medaglia è l’elevato overhead: per ottenere un qubit logico sufficientemente protetto è necessario impiegare centinaia di qubit fisici, con una protezione che cresce aumentando la dimensione della griglia.

Credit immagini nell’articolo: Microsoft EMEA, Microsoft Quantum.

/https://www.ilsoftware.it/app/uploads/2025/12/quantum-computing-novita.jpg)

/https://www.ilsoftware.it/app/uploads/2024/11/2-26.jpg)

/https://www.ilsoftware.it/app/uploads/2026/02/internxt-spazio-cloud-300x120.webp)

/https://www.ilsoftware.it/app/uploads/2024/09/ragionamento-intelligenza-artificiale-open-source.jpg)

/https://www.ilsoftware.it/app/uploads/2026/02/intel-18A-powervia-2026.jpg)