L’intelligenza artificiale sta giocando un ruolo sempre più importante nella risoluzione di problemi complessi e nella creazione di nuove opportunità. Tuttavia, l’accesso ai modelli generativi e alle API corrispondenti richiede una connessione Internet e l’elaborazione su server remoti, il che può sollevare preoccupazioni in tema di disponibilità del servizio, prestazioni e privacy. È qui che entra in gioco LocalAI, una soluzione che risulta pienamente fruibile in ambito locale, senza neppure richiedere una connessione di rete attiva.

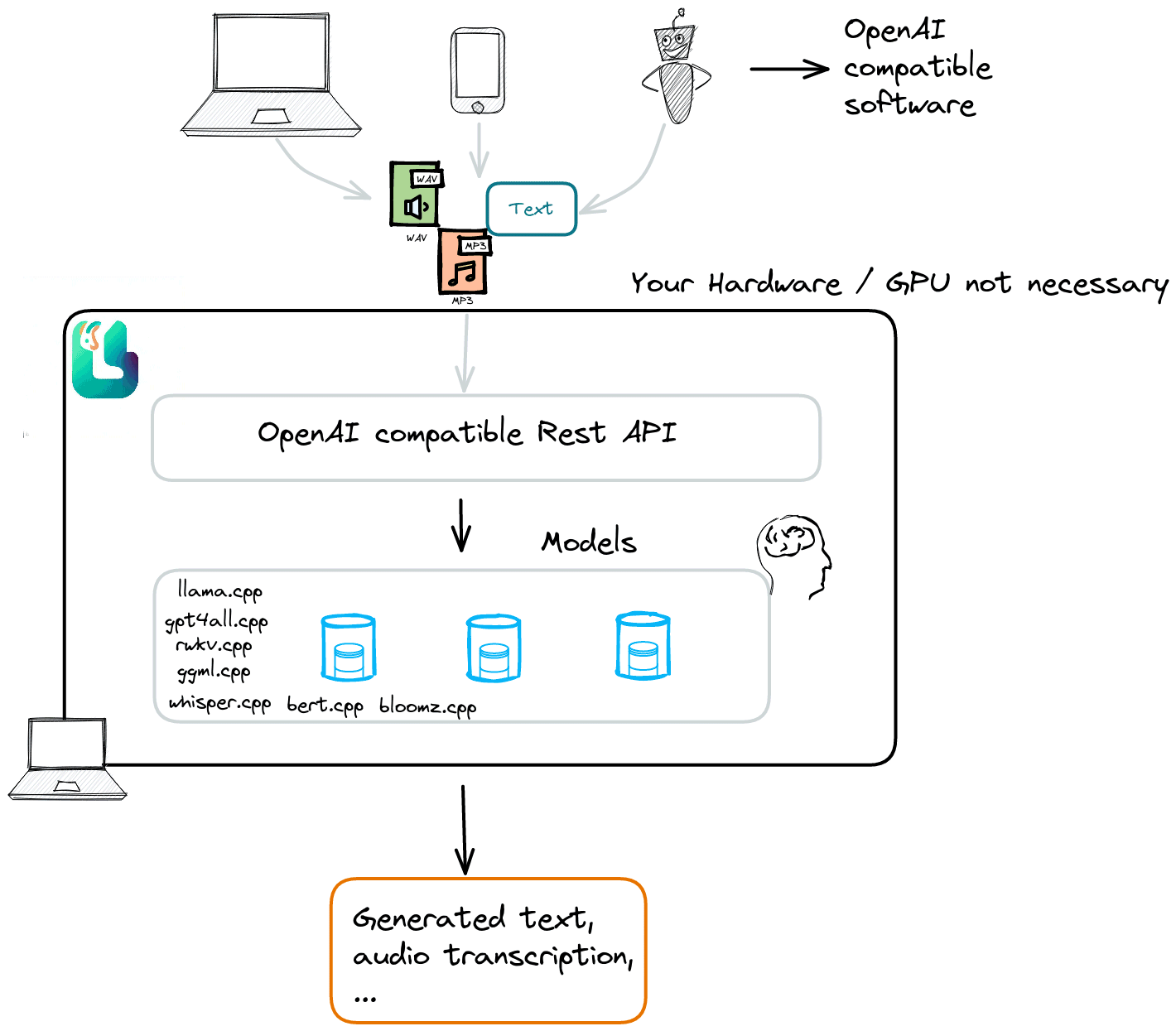

LocalAI è una piattaforma open source, gratuita e completamente locale, che funge da drop-in replacement per le API di OpenAI, Anthropic, ElevenLabs e altre. Consente di eseguire modelli linguistici (LLM), generazione di immagini, audio e video, trascrizioni e sintesi vocale interamente su hardware di uso comune, senza GPU obbligatoria. È una soluzione privacy-first, progettata per funzionare anche on-premise o su piccoli server domestici.

L’idea è di un programmatore italiano, Ettore Di Giacinto, che dopo il lavoro svolto in proprio ha presentato LocalAI come un progetto community-driven, disponibile pubblicamente nel corrispondente repository GitHub.

Diciamo subito che LocalAI vuole essere un’alternativa a OpenAI, pur mantenendo piena compatibilità con i software sviluppati ricorrendo all’SDK dell’azienda guidata da Sam Altman.

Eseguire LocalAI in locale significa sbarazzarsi dei canoni di abbonamento di OpenAI e poter fruire di una piattaforma versatile che raccoglie e supporta i principali modelli fino ad oggi disponibili, anche con hardware di livello consumer.

Cos’è LocalAI e com’è nato il progetto

LocalAI è un’API scritta nel linguaggio Go che funge anche da interfaccia di connessione per i software sviluppati con SDK OpenAI. LocalAI è nata come “progetto del fine settimana” con l’intento iniziale di creare i componenti necessari per un assistente AI completo, simile a ChatGPT. Il progetto è cresciuto rapidamente e ora offre una serie di funzionalità che vanno dalla generazione di testo all’elaborazione audio e visiva.

Nel 2025, LocalAI è diventato parte di una più ampia Local Stack Family, una suite di strumenti interconnessi che estende il concetto di intelligenza artificiale locale. Tra questi figurano:

- LocalAGI, una piattaforma per la gestione di agenti AI locali con capacità di ragionamento e utilizzo di strumenti (abilità agentiche).

- LocalRecall, un sistema RESTful di memorizzazione e conoscenza persistente per agenti AI.

Entrambi i progetti integrano nativamente le API di LocalAI, espandendone le possibilità operative.

Cosa permette di fare LocalAI

L’applicazione integra molteplici funzionalità che consentono di sfruttare modelli di IA direttamente sulla propria macchina senza la necessità di una connessione Internet. Alcune delle funzionalità principali includono:

- Generazione di testo. Supporta la generazione di testo utilizzando modelli come

llama.cppegpt4all.cpp. Questo consente di creare testi coerenti e pertinenti con la possibilità di arricchire le proprie applicazioni con abilità conversazionali. - Conversione di testo in audio e audio in testo. È prevista la possibilità di trasformare il testo in audio e viceversa, aprendo la strada a applicazioni come la sintesi vocale e la trascrizione audio.

- Generazione di immagini. Il sistema per la generazione di immagini utilizza Stable Diffusion consentendo la creazione di immagini artistiche e creative.

- Funzioni OpenAI. LocalAI è compatibile con le principali funzioni di OpenAI, compresi embedding vettoriali e grammatiche vincolate.

Gli embeddings sono rappresentazioni vettoriali di concetti od oggetti in uno spazio multidimensionale. In termini più semplici, sono delle codifiche che catturano le caratteristiche e le relazioni tra gli elementi. Sono utili per migliorare diverse attività di elaborazione del linguaggio naturale e di analisi dei dati.

Le grammatiche vincolate (constrained grammars, in inglese) sono invece regole o modelli di linguaggio che vengono sfruttati per generare testo o sequenze di parole con restrizioni specifiche. In altre parole, invece di generare testo in modo completamente libero, queste grammatiche applicano regole e vincoli specifici in vista della generazione di testi.

Funzionalità avanzate

Gli sviluppatori di LocalAI hanno notevolmente esteso le funzionalità dell’applicazione, includendo:

- Generazione video (l’endpoint

/v1/videosè compatibile con OpenAI). - Object detection e vision API.

- Reranker API per la ri-classificazione semantica dei documenti.

- Inferenza distribuita e P2P, con dashboard di gestione per reti di nodi locali.

- Supporto multimodale (testo, voce, immagine, visione, video).

- MCP – Model Context Protocol, che introduce la possibilità di utilizzare strumenti esterni e controllare dispositivi (anche con Home Assistant).

Modelli compatibili con LocalAI

Una volta acquisiti “una tantum”, LocalAI mantiene caricati i modelli AI in maniera tale da assicurare attività di inferenza più rapide.

Il progetto fa leva su modelli quali i già citati llama.cpp e gpt4all, su rwkv.cpp, ggml, whisper.cpp per le trascrizioni audio, bert.cpp per l’embedding e StableDiffusion-NCN al fine della generazione di immagini. La tabella dei modelli compatibili mostra chiaramente le potenzialità di LocalAI.

Novità di LocalAI 3.7.0

La release 3.7.0 di LocalAI rappresenta uno dei più importanti aggiornamenti nella storia del progetto.

- AI Agents locali: grazie al nuovo framework agentico, è possibile creare agenti autonomi che ragionano, pianificano e utilizzano strumenti esterni, tutto in locale e senza configurazioni complesse.

- MCP (Model Context Protocol): consente agli agenti di interagire con sistemi esterni, come Home Assistant o motori di ricerca, tramite endpoint

/mcp/v1/chat/completions. - WebUI completamente rinnovata: riscritta con Alpine.js, ora è più veloce, responsiva e permette di modificare direttamente da interfaccia le configurazioni YAML dei modelli.

- Nuovo backend audio neutts: basato su Neuphonic, offre voci sintetizzate estremamente naturali e reattive, ideali per assistenti vocali locali.

- Maggiore compatibilità hardware: ora sono disponibili varianti CPU-specifiche per whisper.cpp (AVX, AVX2, AVX512), risolvendo crash su sistemi meno recenti.

Con la versione recentemente pubblicata su GitHub, LocalAI passa da semplice server di inferenza a piattaforma completa per la creazione e l’orchestrazione di agenti AI locali.

Come installare LocalAI in locale

L’installazione di LocalAI è relativamente semplice e può essere effettuata anche su macchine sprovviste di una GPU performante. In precedenza, requisito indispensabile era la presenza del linguaggio Go. Adesso, invece, è possibile sfruttare lo script ufficiale su Linux:

curl https://localai.io/install.sh | sh

Prima di eseguire lo script, potete verificare il contenuto del file install.sh, aprendo l’URL indicato all’interno del vostro browser Web preferito.

In alternativa, LocalAI è disponibile anche come immagine Docker, contenente tutto il necessario per avviare subito il progetto. Di seguito i comandi da usare, a seconda della configurazione hardware in uso:

- CPU only:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest - NVIDIA GPU (CUDA 12):

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12 - AMD (ROCm):

docker run -ti --name local-ai -p 8080:8080 --device=/dev/kfd --device=/dev/dri --group-add=video localai/localai:latest-gpu-hipblas - Intel (oneAPI):

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-gpu-intel

Esistono, infine, anche immagini AIO (All-In-One) già dotate di modelli precaricati per un avvio immediato. Il sistema rileva automaticamente l’hardware disponibile e scarica il backend appropriato (CUDA, ROCm, Intel, Metal, Vulkan o CPU). I modelli possono essere installati direttamente dal catalogo ufficiale o eseguiti con un semplice comando come:

local-ai run llama-3.2-1b-instruct:q4_k_m

Licenza e note finali

LocalAI è distribuito con licenza MIT, confermandosi una delle piattaforme open source più versatili e accessibili per chi desidera sfruttare l’intelligenza artificiale in modo locale, privato e indipendente dal cloud. L’obiettivo del progetto è fornire un’infrastruttura trasparente e completa che permetta di eseguire modelli generativi, di ragionamento e multimodali direttamente in un ambiente on-premises, senza dover affidare i propri dati a server remoti.

Chi utilizza LocalAI può oggi scegliere tra un’ampia gamma di modelli aggiornati e performanti, tra cui Llama 3, Llama 4 (in fase di adozione), Qwen 3 di Alibaba, Gemma 3 di Google DeepMind e persino GPT-oss, il nuovo modello open-weight rilasciato da OpenAI per l’esecuzione locale.

Questi modelli rappresentano la nuova generazione di LLM open source, più efficienti dal punto di vista computazionale e meglio ottimizzati per l’uso con backend come ggml, llama.cpp, gpt4all.cpp e altri già integrati in LocalAI.

In un panorama sempre più orientato al cloud, LocalAI riafferma il valore della sovranità digitale e della libertà di scelta, dimostrando che la potenza dell’AI può essere davvero alla portata di tutti.

Credit immagine in apertura: iStock.com/Vertigo3d

/https://www.ilsoftware.it/app/uploads/2023/08/localai-intelligenza-artificiale-addio-openai.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/openai-prism.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/clawdbot-moltbot-1.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/riconoscimento-facciale-AI-UK.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/chip-microsoft-maia-200-AI.jpg)