/https://www.ilsoftware.it/app/uploads/2023/05/img_13844.jpg)

Sul machine learning si basano molte delle più innovative applicazioni Google. Come generalmente accade, però, il buon software deve basarsi su un’infrastruttura hardware adeguata.

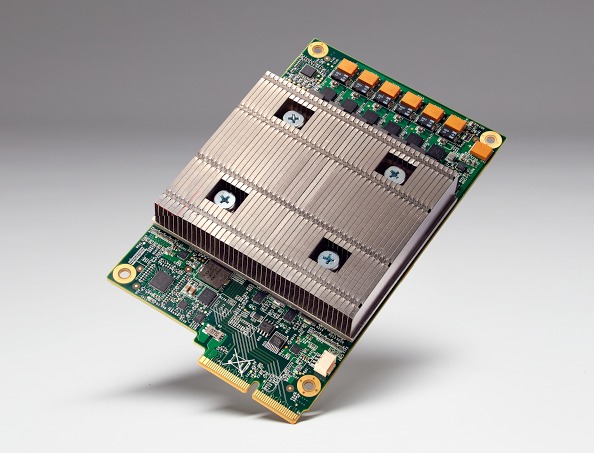

Proprio per questo motivo, Google ha realizzato il chip TPU (Tensor Processing Unit), un processore ASIC (Application Specific Integrated Circuit) che i tecnici della società hanno ideato espressamente per le esigenze legate al machine learning.

Il nome del chip deriva da TensorFlow, il software che funge da “cuore pulsante” per tutti i servizi e le applicazioni Google che usano il deep learning (campo di ricerca dell’apprendimento automatico e dell’intelligenza artificiale che sfrutta gerarchie di caratteristiche di fattori o concetti dove i concetti di alto livello sono definiti sulla base di quelli di livello più basso).

Negli articoli Machine learning: Google presenta TensorFlow e Deep learning, Google presenta il suo corso avanzato abbiamo parlato di TensorFlow di quanto Google vi stia investendo.

Grazie al chip TPU, l’accoppiata hardware e software che governa il funzionamento dell’intelligenza artificiale di casa Google può “apprendere” lo svolgimento di specifici compiti e migliorare il suo comportamento con il trascorrere del tempo.

Secondo Google, che ha provato il funzionamento del chip TPU nei suoi datacenter per oltre un anno, il passo in avanti che il processore ha permesso di compiere in termini di performance per watt sarebbe quantificabile in un ordine di grandezza rispetto alle soluzioni attualmente disponibili per il machine learning.

Un po’ come se la tecnologia avesse compiuto un balzo nel futuro di circa sette anni (tre “generazioni” della legge di Moore).

Le prestazioni “da urlo” sono possibili proprio perché il chip TPU è chiamato a svolgere un compito ben preciso – diversamente dai processori general purpose -. Grazie alla maggiore tolleranza sugli errori computazionali, gli ingegneri Google hanno potuto mettere a punto una circuiteria meno complessa rispetto agli “standard” attuali impiegando quindi un numero notevolmente inferiore di transistor.

Google spiega che rispetto alle tradizionali CPU e GPU, la sua TPU può eseguire molte più operazioni utilizzando la stessa superficie di silicio.

I risultati ottenuti, quindi, mettono in evidenza come il chip TPU sia in grado di surclassare le classiche CPU/GPU sia per prestazioni – ovviamente tenendo ben presente la specifica esigenza per cui è nato il processore di Google – che per riduzione dei consumi energetici.

I tecnici di Google rivelano che il chip TPU è già abbondantemente utilizzato nei datacenter dell’azienda: coadiuva ad esempio il funzionamento di Rankbrain, utilizzato per ottimizzare la pertinenza dei risultati delle ricerche e di Street View, per migliorare la qualità delle mappe e delle indicazioni stradali.

Il chip TPU è stato impiegato anche in AlphaGo, l’intelligenza artificiale che ha ripetutamente battuto il campione del mondo del gioco “Go”: L’intelligenza artificiale di Google batte i campioni di Go.

Nella foto, i server rack utilizzati per affrontare il campione mondiale di “Go” Lee Se-dol.

/https://www.ilsoftware.it/app/uploads/2026/01/NVIDIA-bot-addestramento-AI-annas-archive.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/intel-investimenti-AI-GPU.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/wp_drafter_494577.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/addio-smartphone-asus-AI.jpg)