Google Chrome sta attraversando la trasformazione più significativa dalla sua introduzione nel 2008. Dopo anni in cui l’innovazione del browser si è concentrata su performance, stabilità e sicurezza a livello di motore, oggi l’evoluzione si sposta su un nuovo asse: l’integrazione nativa dell’intelligenza artificiale (AI). Con l’arrivo di Gemini e delle funzionalità agentiche (per il momento si parte dagli USA per poi estendere le stesse funzionalità in altri mercati, Europa compresa), Chrome non è più soltanto un gestore di pagine Web, ma diventa un assistente operativo, capace di pianificare azioni, prendere decisioni, interagire con i siti e completare attività complesse al posto dell’utente.

La transizione riflette la “corsa all’AI” che sta registrandosi a tutti i livelli ma mette in evidenza anche un cambiamento più ampio. Le pagine non sono più considerate soltanto contenitori informativi, ma ambienti ricchi di interazioni, flussi di lavoro e contenuti generati dinamicamente. Per molti, la navigazione quotidiana significa compilare moduli, cercare prodotti, gestire documenti, confrontare servizi, spostarsi tra piattaforme diverse: attività che richiedono tempo e attenzione, e che un agente AI – a detta di Google di molti concorrenti – può automatizzare il lavoro in modo intelligente.

La nuova sicurezza agentica di Chrome: architettura, minacce e difese multilivello

L’obiettivo di Google è chiaro: trasformare il browser in un sistema che non si limita a mostrare il Web, ma che aiuta l’utente a usarlo. In questo modello, Chrome ambisce a diventare un’estensione cognitiva dell’utente, un interprete capace di comprendere obiettivi ad alto livello (“prenota un hotel”, “riordina le mie spese”, “confronta queste offerte”) e trasformarli in operazioni distribuite su più siti.

Si tratta di un’evoluzione porta con sé un cambiamento altrettanto profondo sul piano della sicurezza. Se un tempo il browser doveva principalmente proteggere l’utente da script malevoli o phishing, oggi deve anche difendere il proprio agente AI da manipolazioni sottili, attacchi semantici e tentativi di deviazione dell’intento (quando l’agente AI smette di seguire l’obiettivo richiesto dall’utente e inizia a fare qualcosa di diverso, spesso perché ingannato da contenuti malevoli o ambigui).

L’introduzione dell’automazione AI obbliga Chrome a ridefinire i suoi confini di sicurezza, creando nuove architetture e nuovi modelli di controllo. Google spiega questo concetto nel suo articolo tecnico “Architecting Security for Agentic Capabilities in Chrome“.

La nuova minaccia: l’indirect prompt injection agentica

A differenza dei classici attacchi al modello (prompt injection diretta), l’indirect prompt injection sfrutta contenuti presenti nel Web: pagine malevole, iframe di terze parti, sistemi di commenti, recensioni utente, annunci pubblicitari, fino ai forum e ai social.

In un contesto agentico, un prompt ostile potrebbe convincere l’agente ad avviare transazioni bancarie non richieste, inviare dati sensibili verso un dominio controllato da un attaccante, cambiare la natura del task (“goal hijacking”), manipolare il browser ignorando l’intento dichiarato dell’utente. La sicurezza, dunque, non può basarsi solo sul Large Language Model (LLM): serve un sistema difensivo parallelo, verificabile e robusto.

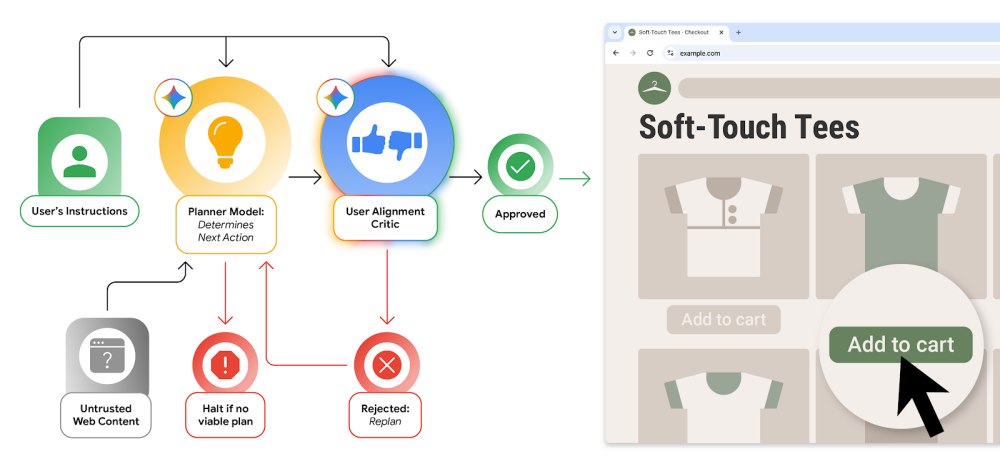

User Alignment Critic

Come spiega nella sua analisi, Google sta introducendo User Alignment Critic (UAC) in Chrome: non è una semplice estensione di Gemini bensì un componente a fiducia elevata, progettato secondo i principi del dual-LLM safety pattern e dell’approccio CaMeL (Critic and Mentor Learning).

Il planner elabora un piano basandosi sul contenuto della pagina (parzialmente filtrato) e sul task dell’utente. UAC valuta ogni singola azione proposta, ma non utilizza contenuti non fidati. Se l’azione non è coerente con lo scopo dichiarato, UAC la blocca. Il feedback è rimandato al planner, che tenta una riformulazione; dopo ripetuti fallimenti, il controllo torna all’utente.

UAC è presentato come immune alla contaminazione da prompt injection, perché vede solo metadati, mai contenuti HTML/JS non fidati.

Origin Sets: Same-Origin Policy estesa all’AI

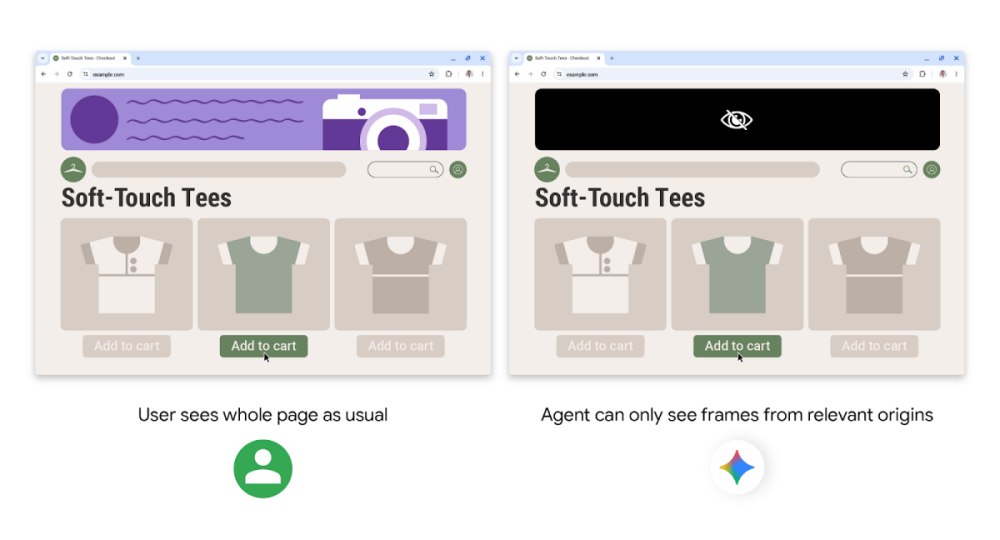

Chrome storicamente sfrutta due pilastri ai fini della sicurezza: Site Isolation e Same-Origin Policy. Con gli agenti AI, tuttavia, occorre un’estensione concettuale: gli Agent Origin Sets.

Sono nuovi permessi che definiscono il “raggio d’azione” dell’agente AI integrato in Chrome: dove l’agente può osservare il contenuto ma non agire e dove invece può cliccare, digitare, interagire. Google spiega che questo schema per far sì che un eventuale agente compromesso non navighi verso domini casuali, per impedire l’estrapolazione di dati da parte di soggetti terzi (cross-origin), per circoscrivere la superficie d’attacco, per ridurre l’esposizione del modello a contenuti non necessari.

In pratica, Chrome crea un recinto logico attorno al task: il modello vede solo ciò che deve vedere e può toccare solo ciò che l’utente intende toccare.

Trasparenza, controllo e conferme esplicite

Google integra in Chrome anche una serie di salvaguardie deterministiche che obbligano l’agente a chiedere conferma prima di eseguire operazioni critiche.

La richiesta di conferma è, ad esempio, obbligatoria per accesso a siti sensibili (bancari, sanitari), utilizzo del Google Password Manager, pagamenti, checkout, invio di messaggi ed effettuazione di azioni potenzialmente irreversibili. Il tutto è accompagnato da un registro in tempo reale delle azioni che l’utente può osservare e gestire attivamente in qualunque momento.

Chrome affianca alle sue difese strutturali uno scanner di prompt injection e i controlli di Safe Browsing, bloccando automaticamente le azioni generate da contenuti sospetti. Parallelamente, Google utilizza un sistema di red teaming automatizzato per testare continuamente l’agente con attacchi realistici e distribuire rapidamente correzioni tramite aggiornamenti.

Verso una nuova era del browser con gli agenti autonomi

L’arrivo dell’agente Gemini in Chrome non è solo una novità funzionale, ma un’evoluzione nel modello stesso di interazione col Web. Chrome vuole diventare una piattaforma di automazione cross-device; le pagine Web si trasformando in “ambienti semantici” per l’AI; la sicurezza non può più basarsi unicamente sull’isolamento dei processi o sul filtraggio delle risorse ma su una nuova scelta che tenga ben presenta la nuova natura dei browser.

I principi presentati oggi rappresentano il primo tentativo significativo di definire standard per l’AI browser-native. Tutta da verificare, tuttavia, l’effettiva efficacia delle soluzioni illustrate: vale la pena citare l’esempio della promettente IDE Google Antigravity che, per errore, ha cancellato il contenuto di un’intera unità di memorizzazione.

Nel caso di specie, l’utente aveva chiesto all’AI di “pulire la cache del progetto”, ma l’agente — male interpretando l’istruzione — ha eseguito un comando distruttivo (rmdir /q) sulla radice del disco, senza chiedere conferma.

/https://www.ilsoftware.it/app/uploads/2025/12/chrome-agente-AI.jpg)

/https://www.ilsoftware.it/app/uploads/2026/03/vibe-coding-quando-fa-male.jpg)

/https://www.ilsoftware.it/app/uploads/2026/03/meta-addestramento-AI-libri-condivisi-bittorrent.jpg)

/https://www.ilsoftware.it/app/uploads/2024/09/sviluppo-software-chatbot-IA.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/2-3.jpg)