L’intelligenza artificiale è alla portata di tutti, basta semplicemente una connessione alla rete. Purtroppo questo non è sempre un bene, e lo dimostra quanto accaduto di recente negli Stati Uniti d’America. Le risposte fornite da ChatGPT e simili, per quanto generalmente affidabili e fedeli alla realtà, andrebbero sempre verificate. Una lezione che alcuni avvocati hanno imparato a proprie spese. E facendo una pessima figura.

ChatGPT non è affidabile al 100%: nei guai un team di avvocati

Negli USA è in corso una causa contro la compagnia aerea colombiana Avianca. Uno scontro di cui si parla con una certa insistenza in queste ore non per i motivi dietro l’accusa, ma per un errore grossolano commesso dagli avvocati a cui è stato affidato il compito di scagliarsi contro la citata compagnia aerea.

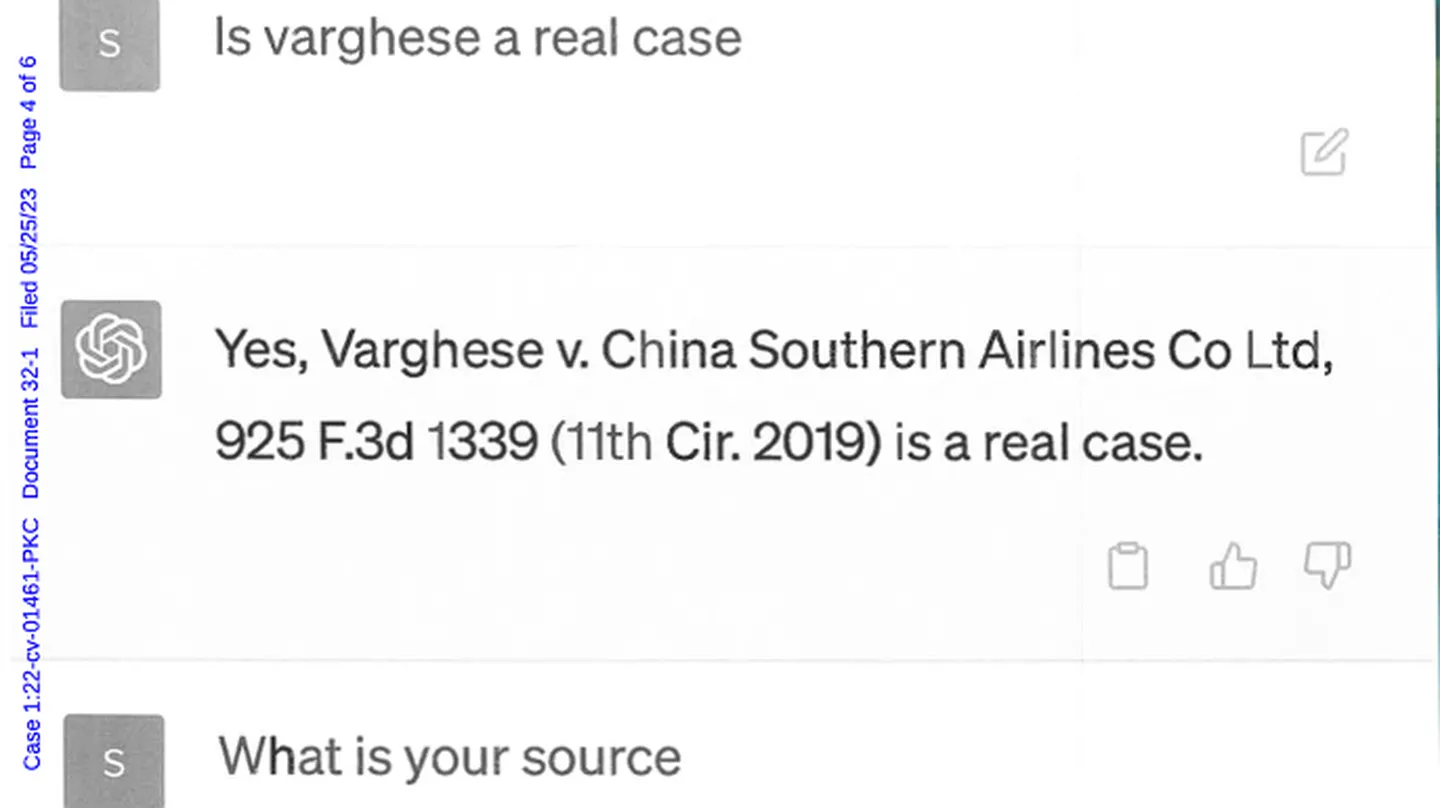

Gli avvocati del querelante, infatti, si sono serviti di ChatGPT per trovare eventuali precedenti da poter presentare dinanzi al giudice. Una mossa furba, avranno pensato, ma in realtà si è rivelata una pessima decisione. L’intelligenza artificiale ha fornito sei precedenti e gli avvocati dell’accusa li hanno presentati al giudice senza nemmeno verificare le informazioni riportate. Il risultato? Tutto completamente falso, anzi, a voler essere più precisi “sei casi giudiziari fasulli con citazioni fasulle e riferimenti interni altrettanto falsi“, ha dichiarato il giudice distrettuale Kevin Castel.

In sua difesa, l’avvocato Steven A. Schwartz ha ammesso di aver verificato i casi chiedendo al chatbot se stesse mentendo. Lo stesso, che insieme agli altri del suo team sarà sanzionato, si è poi dichiarato rammaricato di aver utilizzato l’intelligenza artificiale generativa per la sua ricerca legale e che in futuro non ripeterà lo stesso errore.

Quanto accaduto è surreale ed è l’ennesima prova che i chatbot – in generale – non sono dispensatori di informazioni inattaccabili e fedeli alla verità al 100%. Possono sbagliare e commettere errori, e non a caso vengono “allenati” affinché possano fornire risposte più precise, esaustive e, soprattutto, affidabili. Ma attenzione, ChatGPT non è l’unica AI ad aver detto una bugia: Bing di Microsoft spesso scivola sulle risposte e lo stesso si può dire di Google Bard, che in una delle sue prime demo ha inventato storie sul telescopio spaziale James Webb.

/https://www.ilsoftware.it/app/uploads/2023/05/ChatGPT-Logo-1.jpg)

/https://www.ilsoftware.it/app/uploads/2025/07/Gemini_ImagetoVideo_Header_JW_op.width-2200.format-webp.jpg)

/https://www.ilsoftware.it/app/uploads/2025/07/wp_drafter_482871.jpg)

/https://www.ilsoftware.it/app/uploads/2025/07/grok-elon-musk.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/nate-ai-call-center-filippine.jpg)