Con l’adozione dell’intelligenza artificiale in ogni ambito operativo — dalla produzione all’analisi dei dati, dalla sicurezza alla customer experience — le imprese hanno bisogno di soluzioni robuste, flessibili e indipendenti dal cloud per restare competitive. In questo scenario si inserisce il nuovo QNAP Edge AI Storage Server, una piattaforma integrata progettata per portare la potenza dell’AI direttamente all’interno dell’infrastruttura aziendale.

La soluzione all-in-one di QNAP non si limita a offrire storage ad alte prestazioni, ma integra capacità di calcolo GPU, virtualizzazione avanzata e gestione semplificata di modelli AI e LLM open source. Il risultato è una piattaforma edge pensata per garantire la sovranità dei dati, inferenza locale in tempo reale e un drastico abbattimento dei costi operativi, ideale per aziende che vogliono sviluppare applicazioni AI in ambienti on-premises sicuri, scalabili e a prova di futuro.

Architettura convergente: oltre lo storage, verso l’edge computing intelligente

QNAP Edge AI Storage Server rappresenta un’evoluzione del NAS tradizionale in chiave edge. Basandosi su una piattaforma hardware ad alte prestazioni, dotata di acceleratori GPU e ampie possibilità di espansione PCIe, questo sistema è in grado di eseguire carichi AI in locale, eliminando la dipendenza da servizi cloud.

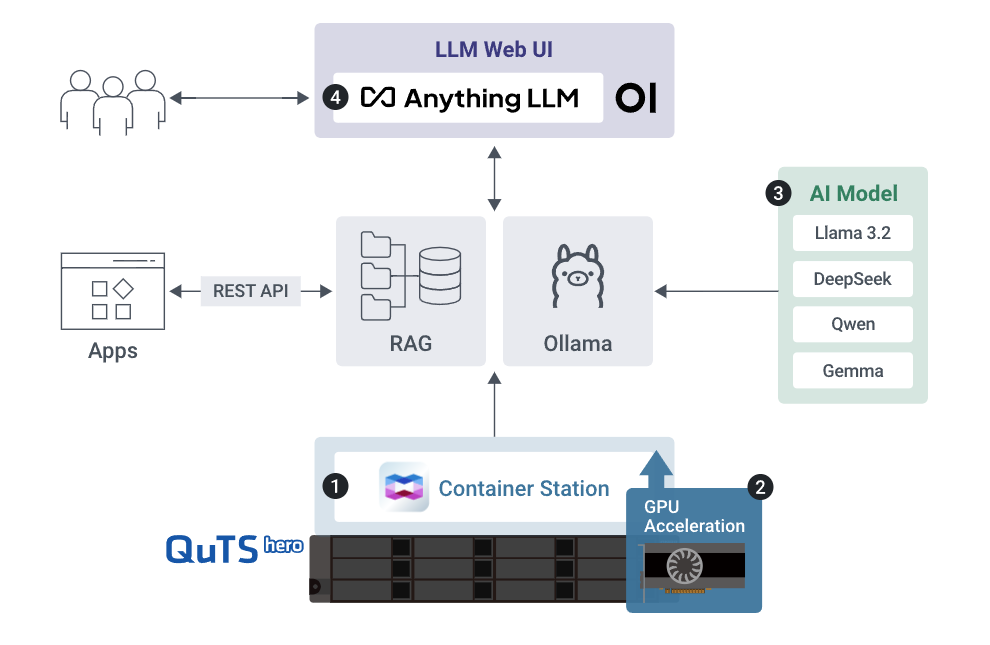

La virtualizzazione tramite Virtualization Station e il supporto nativo a Container Station abilitano una gestione granulare di ambienti AI containerizzati o virtualizzati, fondamentali per l’adozione rapida di modelli open source o privati.

Sicurezza by design e compliance settoriale

La possibilità di mantenere i dati AI e i modelli di inferenza completamente on-premises consente alle aziende di rispettare normative stringenti come GDPR, HIPAA o NIS2, evitando la trasmissione verso servizi cloud esterni.

In settori quali sanità, finanza o manifattura avanzata, dove la sicurezza del dato è mission-critical, l’architettura alla base di QNAP Edge AI Storage Server permette di coniugare prestazioni e compliance.

Ottimizzazione delle risorse e prestazioni quasi-native

Grazie al supporto per GPU passthrough, SR-IOV (Single Root I/O Virtualization, tecnologia di virtualizzazione degli I/O che consente a un singolo dispositivo fisico PCIe – come una scheda di rete o una GPU – di presentarsi al sistema come più dispositivi virtuali indipendenti) e, a breve, l’isolamento delle CPU per workload dedicati, QNAP Edge AI Storage Server consente una distribuzione efficiente delle risorse computazionali tra le macchine virtuali e i container. Questo approccio assicura latenza ridotta e throughput elevato, elementi chiave per il deployment real-time di modelli AI, sistemi di visione artificiale o chatbot in ambito industriale.

AI generativa e LLM: deployment semplice, prestazioni affidabili

Attraverso il supporto per la piattaforma Ollama, è possibile distribuire ed eseguire in locale modelli LLM open source come LLaMA, Qwen, DeepSeek e Gemma, garantendo flessibilità per scenari di sviluppo strumenti NLP interni, knowledge mining o assistenti intelligenti customizzati. La natura containerizzata di questi ambienti consente di effettuare aggiornamenti rapidi, test su nuovi dataset e retraining di modelli proprietari, contenendo al massimo i costi.

La convergenza di più funzionalità all’interno di un’unica appliance consente una drastica riduzione del Total Cost of Ownership (TCO). Oltre a risparmi sulle licenze cloud e sulle risorse IT necessarie per orchestrare ambienti AI frammentati, l’integrazione con strumenti QNAP per il backup, la replica e la gestione centralizzata riduce i tempi di implementazione e manutenzione.

Dove e quando usare QNAP Edge AI Storage Server

Il nuovo QNAP Edge AI Storage Server trova impiego ideale in diversi contesti:

- Smart Manufacturing: analisi predittiva, controllo qualità AI-based e visione industriale.

- Retail intelligente: analisi comportamentale, ottimizzazione delle scorte, sistemi di raccomandazione.

- Sorveglianza avanzata: inferenza video in tempo reale per il rilevamento di anomalie e sicurezza perimetrale.

- Uffici AI-driven: deployment di assistenti conversazionali, automazione documentale e knowledge retrieval.

Note finali

Un dispositivo come il QNAP Edge AI Storage Server rappresenta una pietra miliare nella democratizzazione dell’AI on-premises.

Con un design pensato per la scalabilità, la sicurezza e l’efficienza, permette alle imprese di abbandonare il paradigma cloud-centrico per abbracciare soluzioni ibride o interamente locali, in grado di supportare concretamente la trasformazione digitale.

Grazie all’approccio modulare e compatibile con gli ecosistemi open source, il sistema di QNAP si propone come hub centrale per le applicazioni AI aziendali del futuro.

/https://www.ilsoftware.it/app/uploads/2025/06/Edge-AI-Storage-Server.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/moltbook-openclaw-AI.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/cloudflare-moltworker-middlware-moltbot.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/3-11.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/wp_drafter_495200.jpg)