Jetson Orin è una piattaforma sviluppata da NVidia e progettata specificamente per l’intelligenza artificiale e l’elaborazione dei dati in tempo reale. Si tratta dell'”iterazione” più aggiornata e recente di Jetson, una soluzione che la stessa NVidia svelò addirittura nel 2014.

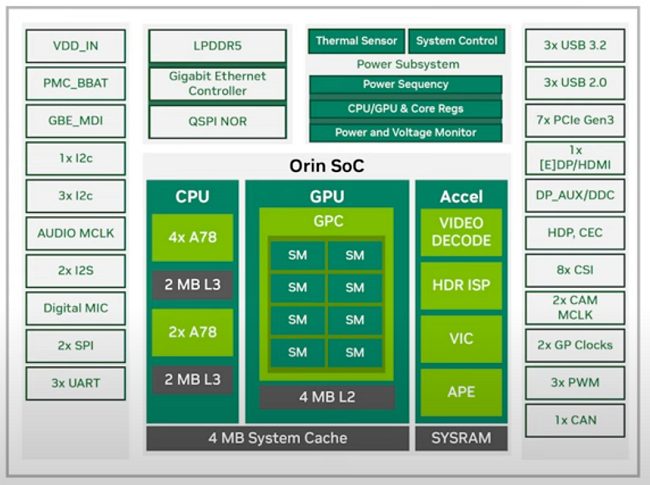

Presentata a settembre 2022, Jetson Orin Nano è una scheda integrata di nuova generazione basata su architettura ARM che offre una potenza di calcolo molto elevata, grazie a 1024 core Ampere lato GPU e fino a 32 Tensor Core.

Il vantaggio di Jetson Orin Nano è che si tratta della prima versione a basso costo dell’intera gamma, capace di mettere nelle mani di sviluppatori, maker e appassionati di tecnologia, un prodotto utile per creare applicazioni per l’intelligenza artificiale su dispositivi embedded.

Mentre le “sorelle maggiori” possono assicurare un’elaborazione dati fino a 275 TeraFLOPS, Jetson Orin Nano arriva comunque fino a 20-40 TeraFLOPS.

Il TeraFLOP è l’unità di misura utilizzata per esprimere la capacità di elaborazione di un sistema informatico, in particolare le sue abilità nell’esecuzione di operazioni in virgola mobile (floating-point operations). Un TeraFLOP indica che il dispositivo è in grado di eseguire 1.000 miliardi di operazioni in virgola mobile al secondo (1012 ovvero la cifra 1 seguita da 12 zeri).

Queste abilità rendono le schede Jetson Orin eccellenti per le applicazioni di intelligenza artificiale avanzate come la guida autonoma, la visione artificiale e la robotica avanzata.

Come si presenta Jetson Orin Nano

Ben 1024 GPU core e fino a 32 Tensor Core non sono qualcosa che si vede tutti i giorni.

I Tensor Core sono un’architettura di elaborazione a bassa precisione sviluppata da NVidia per accelerare l’elaborazione delle operazioni di intelligenza artificiale e di deep learning su GPU. Presenti sulle GPU delle serie Volta, Turing e Ampere, i Tensor Core sono progettati per eseguire operazioni sulle matrici a 16 e 32 bit in parallelo in modo da aumentare significativamente la velocità di elaborazione dei modelli rispetto alle GPU tradizionali garantendo anche una migliore efficienza rispetto a queste ultime (basti pensare che Jetson Orin Nano necessita di una potenza di 7-10W per funzionare).

I core GPU Ampere sono realizzati attingendo all’architettura per processori grafici che NVidia ha annunciato nel 2020.

Jetson Orin Nano integra vari connettori USB, una DisplayPort, i pin GPIO mentre la CPU poggia su 6 core ARM Cortex-A78AE a 64 bit con 1,5 MB di cache L2 e 4 MB di cache L3. La memoria RAM si compone di 8 GB LPDDR5 che assicurano 68 GB/s di banda passante (è disponibile anche una versione “ridotta” della scheda Orin Nano con 4 GB di RAM).

Una scheda come Jetson Orin Nano, il cui Developer Kit è presentato in questo video YouTube, ha una potenza che può essere quantificabile in circa 70-80 volte quella di una Raspberry Pi. Le sue prestazioni superano di 80 volte quelle della scheda Jetson Nano del 2014, citata in apertura.

È interessante evidenziare come gli sviluppatori di NVidia abbiano messo a disposizione dei professionisti che si occupano di modelli generativi e di applicazioni per l’intelligenza artificiale in generale uno strumento come PeopleNet-Transformer.

In altri articoli abbiamo già visto cosa sono i Transformer, un tipo di architettura di rete neurale utilizzata in molti modelli per l’intelligenza artificiale, in particolare nella modellizzazione del linguaggio naturale.

La caratteristica principale dei Transformer è l’uso dell’attenzione (“attention”; il documento che ha di fatto segnato la nascita delle moderne applicazioni di intelligenza artificiale è quello elaborato a fine 2017 da un team di Google e di esperti accademici dal titolo Attention is all you need) ovvero una tecnica che permette di dare maggior peso alle parti rilevanti dell’input durante l’elaborazione, senza la necessità di utilizzare una struttura sequenziale fissa come nei modelli di rete neurale ricorrente (RNN). I Transformer sono in questo modo particolarmente efficaci nel trattare sequenze di dati molto lunghe, come ad esempio frasi o interi documenti.

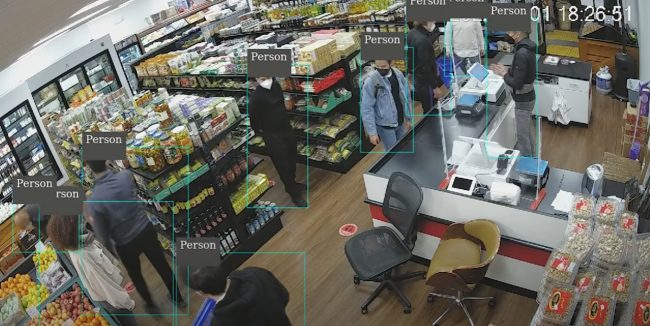

Il modello PeopleNet-Transformer è in grado di riconoscere automaticamente alcune tipologie di oggetti fisici raffigurati in un’immagine e applicare un’etichetta a ciascuno di essi.

PeopleNet-Transformer è stato addestrato usando un dataset proprietario composto da oltre 1,5 milioni di immagini e più di 39 milioni di oggetti singoli per ciascuna categoria. Intorno a ciascun oggetto riconosciuto, il modello può disporre un riquadro colorato per evidenziarlo in modo chiaro. Ecco, una scheda come Jetson Orin Nano consente di arrivare a gestire fino a 100 frame per secondo con il modello in esecuzione.

L’effetto è visibile in questo video (la foto è di NVidia).

Come le altre schede della stessa linea, Jetson Orin Nano offre supporto per una vasta gamma di librerie largamente impiegate nell’ambito delle soluzioni per l’intelligenza artificiale tra cui TensorFlow, PyTorch e Caffe, in grado di semplificare lo sviluppo dei modelli di apprendimento automatico.

Pensate alla semplicità con cui gli sviluppatori possono implementare algoritmi di apprendimento automatico e di visione artificiale che funzionano in tempo reale su un dispositivo a bassa potenza; alla riduzione delle tempistiche per la realizzazione delle applicazioni di robotica, automazione industriale, sicurezza e videosorveglianza, gestione dei flussi aziendali e molto altro ancora che diventano semplici da mettere a punto, da gestire e poco costose da mantenere.

Riflettete ancora sul fatto che grazie a Jetson Orin Nano, una scheda che ha l’abbordabilissimo costo di circa 450 euro, si possono ad esempio creare sistemi basati sull’intelligenza artificiale in grado di prendere decisioni autonome senza dover ricorrere a server remoti.

/https://www.ilsoftware.it/app/uploads/2023/05/img_25852.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/demis-hassabis-deepmind-contro-pubblicita-chatgpt.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/satya-nadella-AI-deve-essere-utile.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/curl-stop-bug-bounty-AI.jpg)

/https://www.ilsoftware.it/app/uploads/2024/07/grok.jpg)