La necessità di organizzare e indicizzare contenuti video personali è cresciuta esponenzialmente, complice la diffusione di dispositivi di registrazione sempre più accessibili e potenti. GoPro, smartphone, droni e videocamere di sicurezza generano ogni giorno gigabyte di materiale che rimane spesso inutilizzato, perché trovare scene specifiche all’interno di archivi così vasti è sempre un problema. Le soluzioni cloud, come Google Video Intelligence API, offrono funzionalità di analisi avanzata, funzionano molto bene ma presentano due limiti difficilmente superabili in ambito personale e professionale: il costo elevato e la necessità di caricare online contenuti che, nella maggior parte dei casi, contengono informazioni riservate.

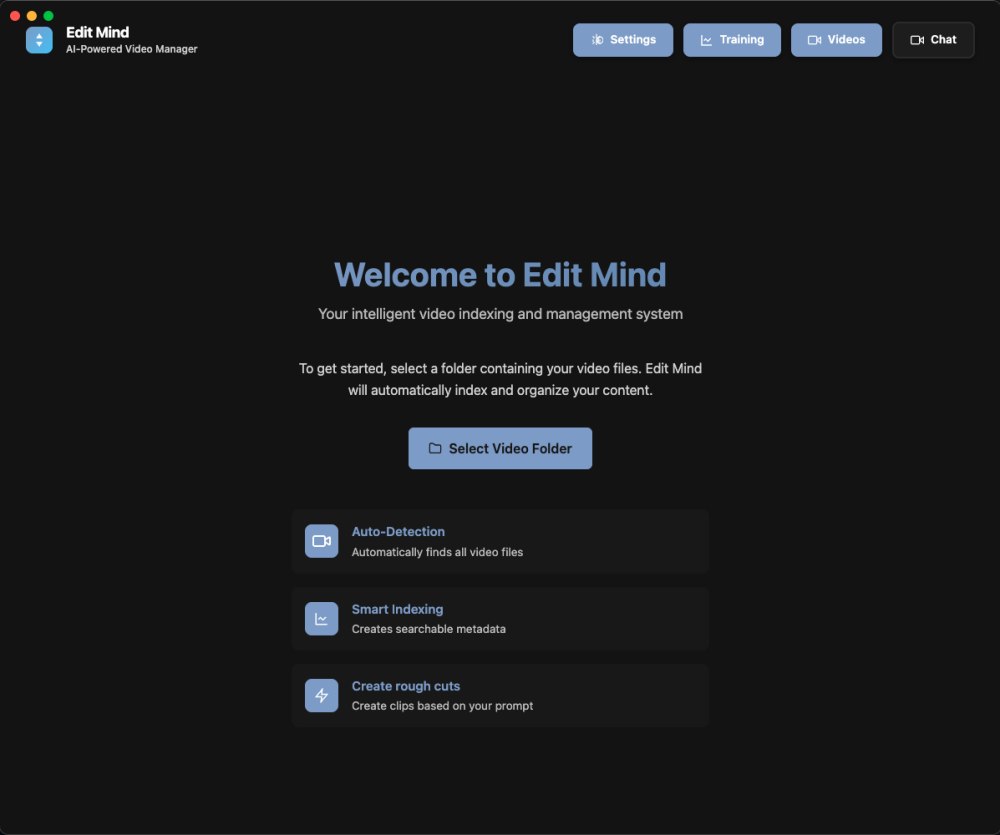

C’è un nuovo progetto che ci ha colpito davvero positivamente: si chiama Edit Mind, è pubblicato su GitHub sotto licenza MIT e propone un approccio radicalmente diverso: spostare l’intelligenza artificiale dal cloud al desktop. L’idea alla base è tanto semplice quanto potente: permettere all’utente di costruire un proprio motore di ricerca video, capace di “comprendere” il contenuto dei filmati e di rispondere a query in linguaggio naturale, senza mai inviare un singolo frame fuori dal computer o dalla propria infrastruttura.

L’applicazione si presenta come una piattaforma self-hosted, sviluppata con tecnologie moderne come Electron, React e Python, che trasforma una libreria video locale in un archivio semantico consultabile e completamente privato.

Panoramica funzionale di Edit Mind

Il principio architetturale di Edit Mind si fonda su una pipeline di analisi multimodale. Ogni video è suddiviso in segmenti di pochi secondi, trattati come unità autonome su cui vengono applicati modelli di machine learning per la trascrizione audio, il riconoscimento dei volti, la rilevazione degli oggetti e l’analisi visiva dei colori e delle emozioni.

Il risultato è un insieme di metadati ricchi e coerenti che descrivono non solo ciò che viene detto, ma anche ciò che accade visivamente in ogni scena. Tutte le informazioni generate sono poi tradotte in rappresentazioni vettoriali, gli embeddings, e salvate localmente in un database vettoriale ChromaDB.

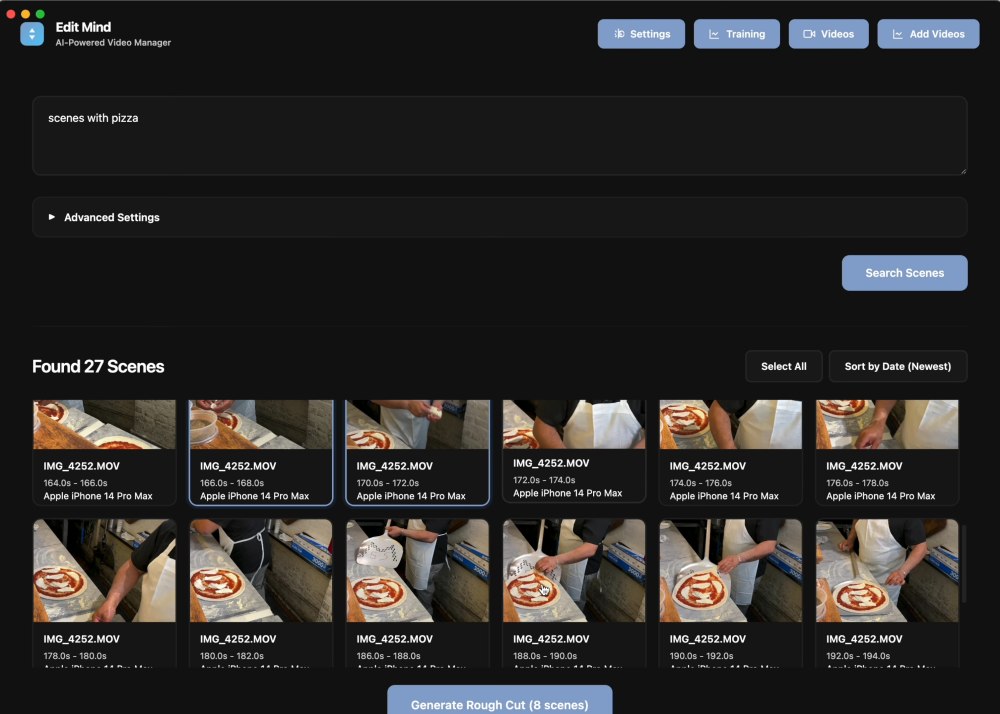

Proprio grazie a questo approccio, è possibile interrogare il sistema non con parole chiave rigide, ma con richieste semantiche del tipo “mostrami le scene in cui Marco ride al mare” o “tutti i momenti in cui due persone parlano di notte”.

Le principali abilità

- Indicizzazione locale: trascrizione audio, OCR, rilevamento oggetti (YOLOv8), riconoscimento volti, analisi di emozioni e colori dominanti.

- Segmentazione: Edit Mind suddivide il video in “scene” temporali (es. frammenti di 2 secondi) per un’indicizzazione “a grana fine”.

- Vettorializzazione: embeddings testuali e multimodali salvati in un supporto ChromaDB locale per la ricerca semantica.

- Parsing di query naturali: trasforma prompt in query strutturate (attualmente usa le API Gemini ma supporta LLM locali come quelli gestibili con Ollama).

- Rough-cut export: selezione e assemblaggio rapido di clip, esportabili come video e (in futuro) FCPXML/PRJ.

- Plugin system: grazie al sistema basato su plugin, è possibile estendere le abilità di Edit Mind (i.e. rilevamenti di eventi audio, visualizzazione di logo e così via).

Architettura tecnica

Il valore tecnico di Edit Mind risiede nella capacità di orchestrare strumenti complessi in un ambiente coeso e accessibile. FFmpeg gestisce la manipolazione dei video, OpenAI Whisper esegue la trascrizione audio con accuratezza temporale, mentre YOLOv8 e librerie Python dedicate si occupano dell’analisi dei frame.

Una sinergia che consente una comprensione profonda dei contenuti multimediali, capace di restituire risultati con una granularità sorprendente. L’applicazione permette, inoltre, di selezionare le clip più rilevanti e di esportarle in forma di rough cut (montaggi grezzi pronti per essere utilizzati), con supporto pianificato per i formati di Final Cut Pro e Adobe Premiere Pro, rendendo Edit Mind uno strumento utile non solo per la catalogazione, ma anche per la produzione video.

Dal punto di vista delle prestazioni, l’analisi iniziale di una libreria con Edit Mind può essere impegnativa: il sistema impiega mediamente da due a tre ore di elaborazione per ogni ora di video, con un consumo di memoria che varia tra i 5 e gli 11 GB, a seconda della complessità dei contenuti e dei plugin attivi.

Tuttavia, questa fase è necessaria solo una volta e rappresenta l’investimento computazionale che permette di beneficiare, in seguito, di una ricerca istantanea. L’autore del progetto sottolinea come la scalabilità locale sia sorprendentemente efficiente rispetto alle alternative cloud, dove la stessa analisi avrebbe richiesto un esborso superiore ai 1.500 dollari solo per il suo archivio personale pesante circa 2 Terabyte.

Installazione, configurazione e utilizzo pratico

Per installare Edit Mind su un sistema macOS, Linux o Windows, è necessario predisporre un ambiente con Node.js (versione 22 o superiore) e Python (almeno 3.9).

Dopo aver clonato il repository ufficiale con il comando git clone https://github.com/iliashad/edit-mind, si entra nella directory del progetto ed è possibile installare i moduli JavaScript eseguendo npm install. Questa fase prepara il lato Electron/React dell’applicazione.

Successivamente si configura la parte Python, che fa funzionare il motore di analisi AI. Si crea un ambiente virtuale — per esempio con python3 -m venv .venv — che poi si attiva tramite source .venv/bin/activate su Linux e macOS, oppure .\.venv\Scripts\activate su Windows. Una volta attivo l’ambiente, l’installazione delle dipendenze avviene con pip install -r requirements.txt seguita da pip install chromadb.

A questo punto, prima di avviare il software, è necessario eseguire il server di ChromaDB, che rappresenta il cuore dell’indicizzazione semantica.

Il comando chroma run --host localhost --port 8000 --path .chroma_db crea un’istanza locale del database, salvando gli embeddings e i metadati direttamente sul disco. In parallelo, il progetto richiede una chiave API di Google Gemini per interpretare in linguaggio naturale le query dell’utente e generare embeddings testuali: il parametro va inserito in un file .env posto nella radice del progetto, con la riga GEMINI_API_KEY=inserire_api_key. Dopo aver completato la configurazione, il sistema è pronto per l’avvio vero e proprio. Il comando npm run start lancia l’applicazione in modalità di sviluppo, aprendo la finestra Electron con la dashboard principale.

Selezione dai video da elaborare

All’interno dell’interfaccia di Edit Mind, l’utente può importare i video tramite drag & drop o selezione da file system. L’indicizzazione avviene interamente in locale e consiste in una pipeline multipla che scompone i file in “scene” di circa due secondi ciascuna, come anticipato in precedenza.

Per ogni segmento, Edit Mind avvia il modulo di trascrizione audio, basato su una versione locale del modello Whisper. Parallelamente, le scene sono analizzate da una serie di plugin Python che individuano volti, oggetti, testo visibile e dominanti cromatiche. Il risultato è un archivio strutturato di metadati in formato JSON, sincronizzato con i timestamp del video originale e archiviato in ChromaDB sotto forma di vettori semantici.

![]()

Durante la fase di ricerca, l’utente può interrogare la libreria usando il linguaggio naturale: la richiesta è convertita dal modello Gemini in una query strutturata che passa in locale sul database vettoriale. Il sistema restituisce una serie di miniature o anteprime dei segmenti corrispondenti, ordinati per rilevanza. È quindi possibile riprodurli, esportarli come clip singoli oppure comporli in un rough cut automatico, con una sequenza gestibile avvalendosi di programmi quali DaVinci Resolve, Premiere o Final Cut.

Creare un pacchetto da usare in produzione

Per chi desidera installare Edit Mind in modo permanente, è possibile generare un pacchetto nativo. L’installer prodotto nella directory \out integra tutti i componenti Node.js e React, mentre il runtime Python resta esterno ed è configurato automaticamente al primo avvio.

In un contesto aziendale o di laboratorio, l’app può essere distribuita in rete locale insieme a un’istanza centralizzata di ChromaDB, consentendo ricerche condivise su librerie video comuni mantenendo comunque l’elaborazione AI lato client.

Conclusioni

I dati audiovisivi possono rivelare informazioni biometriche, relazionali e comportamentali. Edit Mind è la prova provata che c’è la concreta possibilità di mantenere l’intero ciclo di elaborazione all’interno della propria infrastruttura, godendo di un vantaggio etico e tecnico insieme.

Il progetto restituisce il controllo all’utente, dimostrando che l’analisi avanzata dei contenuti non è prerogativa dei grandi cloud provider, ma può esistere anche come servizio personale, trasparente e rispettoso della privacy.

Naturalmente, il progetto è ancora in fase di sviluppo attivo e presenta sfide non trascurabili. Il packaging dell’ambiente Python e dei modelli di intelligenza artificiale all’interno dell’app Electron è un tema complesso, così come l’ottimizzazione delle prestazioni su hardware consumer e la gestione dell’evoluzione dello schema dei dati. Tuttavia, la scelta di una licenza MIT e di un’architettura modulare invita alla collaborazione della comunità, che può contribuire con plugin, ottimizzazioni e nuove funzionalità.

Un grande vantaggio arriverà con l’integrazione di Edit Mind sulle piattaforme già utilizzate per l’archiviazione e la condivisione (Immich, Photoprism, Nextcloud,…) nonché con l’eventuale rilascia di un’immagine Docker pronta da usare.

Le immagini contenute nell’articolo sono tratte dalla demo YouTube dello sviluppatore di Edit Mind.

/https://www.ilsoftware.it/app/uploads/2025/10/ricerca-video-locale-edit-mind.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/Disney-offerta-3-mesi.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/Juventus-Benfica-streaming-gratis.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/Disney-nuova-offerta.jpg)

/https://www.ilsoftware.it/app/uploads/2026/01/HBO-Max-Prime-Video.jpg)